Schnee in Kamtschatka: Virales Schlitten-Video ist mutmaßlich KI-generiert

Ein Video zeigt Kinder, die in Kamtschatka in Russland einen Schneehügel herunterrodeln. Der reicht fast bis zum Dach eines Hauses – eine Aufnahme, die einige Medien aufgriffen. Das Video ist jedoch wahrscheinlich KI-generiert.

„Die Kinder haben ihren Spaß daran“, schreibt ein X-Nutzer über ein Video, das aus Kamtschatka, einer russischen Halbinsel im Pazifik, stammen soll. Dort gab es im Januar 2026 laut Meteorologen die schwersten Schneefälle seit Jahrzehnten – tagelang berichteten Medien über Schneemassen und -verwehungen. In dem Video rutschen scheinbar mehrere Kinder fröhlich einen großen Schneehaufen herunter. Es sieht so aus, als türmte sich der Schnee fast bis zum Dach eines etwa neunstöckigen Gebäudes.

Auf X teilte es unter anderem die prorussische Bloggerin Alina Lipp, die auf der Sanktionsliste der EU steht. Zudem griffen es mehrere deutsche Medien auf, die sich später korrigierten. Uns erreichte das Video außerdem mehrfach über unseren Chatbot mit der Bitte um Prüfung.

Der Fall zeigt: Es ist nicht mehr so leicht, KI-generierte Videos zu enttarnen. Die international virale Aufnahme wirkt aus mehreren Gründen unrealistisch, wie unser Faktencheck zeigt.

Angebliches Schlitten-Video aus Kamtschatka offenbar mit Sora 2 erstellt

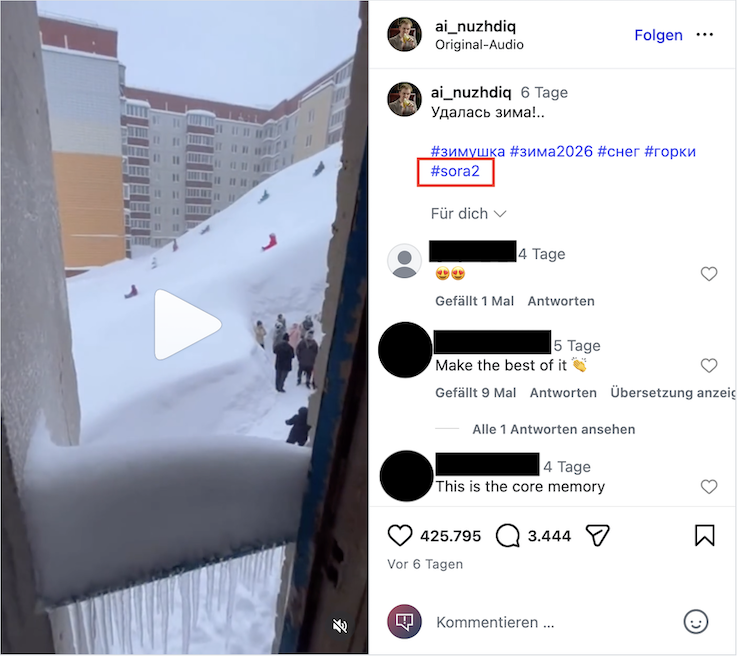

Eine Bilder-Rückwärtssuche führt zu Instagram-Beiträgen, in denen ein Nutzername sichtbar ist: ai_nuzhdiq. Der Nutzer nennt sich in seinem Profil „digital creator“, teilt immer wieder offensichtlich KI-generierte Inhalte und hat das Video in der Nacht zum 16. Januar 2026 auf Instagram geteilt, also bevor es in Medienberichten und anderen Posts auftauchte – sein Beitrag hat inzwischen mehr als 17 Millionen Aufrufe. Eine ältere Version des Videos konnten wir nicht finden. Auf Nachfrage, ob der Nutzer Urheber des Videos ist, antwortete er bis zur Veröffentlichung dieses Faktenchecks nicht.

Der Nutzer nennt in der Beschreibung das KI-Tool Sora 2 von Open AI, über das wir schon mehrfach berichtet haben. Normalerweise haben Videos, die mit dem Tool erstellt werden, ein Wasserzeichen. Dieses lässt sich jedoch leicht entfernen. Die meisten Videos des Instagram-Nutzers wurden laut Beschreibung mit Sora 2 erstellt. Open AI schreibt auf Nachfrage, das Video sei nicht mit Sora 2 erstellt worden. Der Nutzer verlinkt jedoch in seinem Profil ein Programm auf Telegram, das offenbar die Sora-KI nutzt, um Videos zu generieren.

Experten sehen Hinweise, dass das Video künstlich erstellt wurde

Valentin Schwind, Professor für Computergrafik an der Hochschule der Medien in Stuttgart, schreibt uns auf Nachfrage, die übertrieben hohen Schneeverwehungen seien ihm auf Tiktok ins Auge gefallen, denn in anderen Aufnahmen seien eher normale Größenverhältnisse zu sehen. Zudem sei im konkreten Fall ein Kind auf einem Schlitten auffällig, weil es wie ein „Geist“ flackere.

Gemeint ist das zweite Kind, das den Berg hinunterrodelt. Es verschwimmt fast mit dem Schnee im Hintergrund.

Martin Steinebach ist Abteilungsleiter für Media Security und IT Forensics am Fraunhofer-Institut für Sichere Informationstechnologie – er schreibt, er könne gut verstehen, dass das Video für echt gehalten wurde. „Ohne technische Analysen kommt man hier schnell an den Punkt, bei dem man sich fragt, ob man jetzt Hinweise sieht oder sie nur sehen will.“

Steinebach nennt einen weiteren Hinweis, der stutzig machen sollte: Im Video sehe man im Schnee ein Kind in dunkler Kleidung laufen, das dann plötzlich zu wachsen scheine und ein anderes Kind an der Hand nehme.

Ebenfalls auffällig ist die Hand eines Kindes, das gegen Ende des Videos ins Bild kommt, und ebenfalls unnatürlich groß wird:

Schnee in Kamtschatka reichte laut Deutschem Wetterdienst maximal in den vierten Stock

Unabhängig von diesen technischen Fehlern, ist das Video unrealistisch: Zwar gab es in Kamtschatka starke Schneeverwehungen, laut Medienberichten waren sie aber nicht so hoch wie in dem Video. Reuters zufolge fielen im Dezember und Januar etwas mehr als fünf Meter Schnee, auch die Tagesschau berichtet ähnlich. Der deutsche Wetterdienst verweist uns auf Anfrage auf einen Artikel, wonach die Schneeverwehungen maximal in den vierten Stock reichten. Aufnahmen von Medien und Nachrichtenagenturen belegen eingeschneite Hauseingänge und Autos – jedoch keinen so hohen Schnee wie im Video.

Ist die Rodelszene realistisch dargestellt? Das haben wir den Deutschen Skiverband (DSV) gefragt. Laut Andreas König, Geschäftsführer beim DSV aktiv, wirken die Rodler und Skifahrer auf den Schneehügel „draufgesetzt“. Die Fahrgeschwindigkeit scheine zudem nicht zum Gefälle des Schneehügels zu passen. Die Rodler beziehungsweise Skifahrer seien zu langsam unterwegs.

Medien haben das Video teilweise gelöscht und einen Hinweis gesetzt

Das Video wurde auch in mehreren deutschsprachigen Medienberichten verwendet. Die Nachrichtenseiten T-Online und Watson korrigierten ihre Artikel mit einem Hinweis, dass das Video KI-generiert ist. T-Online löschte zudem einen Facebook-Beitrag mit 400.000 Aufrufen. Focus und Welt haben nach unserer Anfrage ihre Artikel jeweils angepasst und ebenfalls einen Hinweis gesetzt.

Alina Lipp antwortete nicht auf eine Anfrage von CORRECTIV.Faktencheck – ihre Beiträge sind weiterhin online. Sie schrieb auf X sinngemäß, dass es für sie keinen Unterschied mache, wenn einige der von ihr geteilten Videos KI-generiert seien.

Mitarbeit: Laura Seime

Redigatur: Sarah Thust, Gabriele Scherndl