Medien nutzten wohl KI-Video für Berichterstattung über Kamtschatka

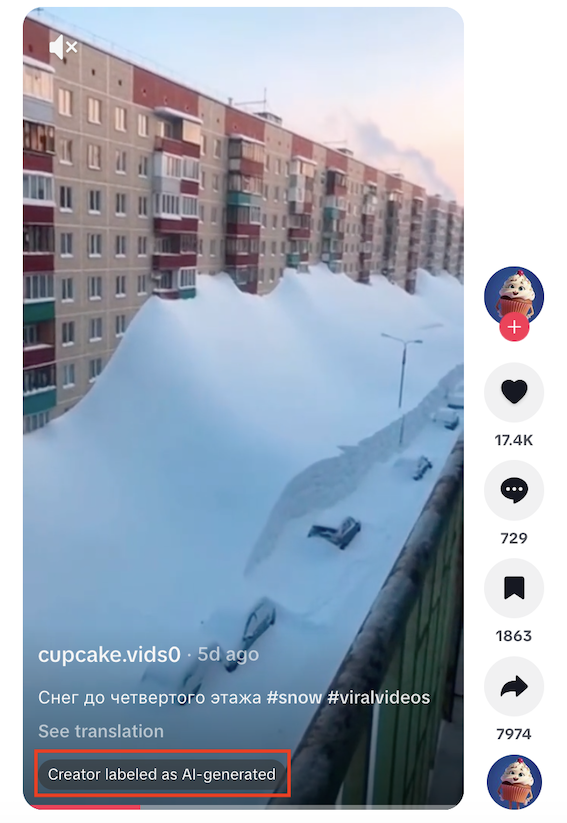

Ein Video zeigt Schnee an einer Häuserfront, mehrere Stockwerke sind eingeschneit. Einige deutschsprachige Medien verbreiteten die Aufnahme als authentisches Material aus Kamtschatka. Doch sie ist offenbar KI-generiert.

Bild, Welt, Focus und T-Online: Diese Medien haben ein kurzes Video als Teil ihrer Berichterstattung über den starken Schneefall auf der russischen Halbinsel Kamtschatka aufgegriffen – und es mittlerweile gelöscht. „Ganze Wohnblöcke versinken im Schnee“, schrieb T-Online, oder „Schnee bis in den neunten Stock“ die Welt. Das Video zeigt eingeschneite Autos und Schneeberge, die mehrere Stockwerke von Häusern bedecken.

Doch die Bilder stammen höchstwahrscheinlich von einem Tiktok-Account, der mithilfe von künstlicher Intelligenz (KI) generierter Inhalte Millionen Klicks bekommt. Auch in den Sozialen Netzwerken wurde das Video verbreitet – etwa von der pro-russischen Bloggerin Alina Lipp. Focus und Welt gaben Lipp, die auf der Sanktionsliste der EU steht, als Quelle an.

Daran, dass es sich um eine authentische Aufnahme handelt, gibt es Zweifel. Laut Experten gibt es kleinere Auffälligkeiten im Video, die auf KI hindeuten – der Fall zeige jedoch auch, wie schwer es mittlerweile offenbar für größere Redaktionen sei, KI-erzeugte Inhalte zu erkennen.

Mutmaßlicher Urheber hatte Video auf Tiktok als KI-generiert markiert

Der früheste Beitrag mit dem Video, den wir finden konnten, stammt von einem Tiktok-Account namens „Cupcake Videos“. Auf unsere Nachfrage reagierte der Account nicht. Mittlerweile ist er samt Video nicht mehr abrufbar, auch ein entsprechender Youtube-Kanal ist offline.

Archivierte Beiträge belegen jedoch, dass der Account mehrere KI-generierte Videos über den Schnee in Kamtschatka verbreitet hatte und diese auch entsprechend markierte – in englischer Sprache stand in der App unter dem im Video: „vom Ersteller als KI-generierter Inhalt markiert“. Auch bei Youtube hatte der Account laut der Faktencheck-Redaktion der AFP in der Beschreibung stehen, dass die Videos künstlich erzeugt wurden.

Experten verweist auf zwei mögliche KI-Artefakte

Wir haben Experten um eine Einordnung dazu gebeten, ob man das Video sicher als KI-generiert bezeichnen kann. Valentin Schwind, Professor für Computergrafik an der Hochschule der Medien in Stuttgart, schreibt uns auf Nachfrage, ihm seien zwei Dinge aufgefallen: Ein verzerrter Laternenmast und zwei Autos, die scheinbar ineinander stecken:

Martin Steinebach, Abteilungsleiter für Media Security und IT Forensics am Fraunhofer-Institut für Sichere Informationstechnologie, findet, der Rauch im Hintergrund sei verdächtig, er mache ein paar „Sprünge“ in seiner Form. Dies könnten aber auch Böen sein. Grundsätzlich könne er verstehen, warum das Video für echt gehalten worden sei. „Ohne technische Analysen kommt man hier auch schnell an den Punkt, bei dem man sich fragt, ob man jetzt Hinweise sieht oder sie nur sehen will“, so der Experte.

Experte warnt: „KI-generierte Videos werden bald von echtem Material nicht mehr zu unterscheiden sein“

Diese Einschätzung teilt auch Schwind, er warnt: „KI-generierte Videos werden bald von echtem Material nicht mehr zu unterscheiden sein, mit erheblichen Konsequenzen.“ Er schreibt auch, Bild- und Videomaterial sollten heute grundsätzlich als potenziell gefälscht angesehen werden, solange eine Aufnahme nicht technisch verifiziert sei. Genau daran würden derzeit viele Redaktionen scheitern. „Meiner Einschätzung nach müssen – und werden – Journalistinnen und Journalisten wieder stärker als Augenzeugen vor Ort arbeiten“, schreibt er. Sich primär auf Social-Media-Videos zu stützen, sei problematisch.

Im Winter 2025/2026 hat es in Kamtschatka starke Schneefälle und Schneeverwehungen gegeben. Reuters zufolge fielen im Dezember und Januar etwas mehr als fünf Meter Schnee, auch die Tagesschau berichtet ähnlich. Der deutsche Wetterdienst verweist uns auf Anfrage auf einen Artikel, wonach die Schneeverwehungen maximal in den vierten Stock reichten. Aufnahmen von Medien und Nachrichtenagenturen belegen eingeschneite Hauseingänge und Autos.

Im Vergleich zu diesen Aufnahmen erscheint es jedoch seltsam, dass im Video kaum Schnee auf den flachen Dächern, dem oberen Teil der Fassade und an den Balkonen zu sehen ist. Der Schnee wirkt allgemein sehr plastisch und glatt, auch dass er an der Fassade und vor den Autos mit einer beinahe glatten Linie abschließt, ist unüblich:

Medien entfernten Video und setzten Korrekturhinweise

Alina Lipp reagierte nicht auf unsere Anfrage – auf X erklärte sie sinngemäß, dass es für sie keinen Unterschied mache, wenn einige der von ihr geteilten Videos KI-generiert seien. Focus und Welt antworten nicht auf unsere Nachfrage, warum Lipp als vertrauenswürdige Quelle eingeschätzt wurde.

Focus und Bild erklärten auf Nachfrage, dass das Video aus den entsprechenden Beiträgen entfernt worden sei. Ein Bild-Pressesprecher schrieb uns, es habe von den Schneemassen verifizierte Agenturbilder und -videos gegeben, die zu dem wahrscheinlich KI-generierten Video stimmig erschienen. T-Online und Welt antworteten bis zur Veröffentlichung nicht auf unsere Anfrage.

Es sind nicht die einzigen falschen Bilder aus Kamtschatka, die Lipp und einige deutsche Medien teilten. Ein Video von Januar 2026 sollte Kinder in Kamtschatka zeigen, die einen Schneehügel herunterrodeln – der reichte bis etwa zum neunten Stock. Warum das übertrieben ist, haben wir hier berichtet.

Mitarbeit: Laura Seime

Redigatur: Sara Pichireddu, Max Bernhard