Alles heiße Luft, trotzdem viral: Wieso dieser KI-Fake zu einem Putin-Ballon Zehntausende erreicht

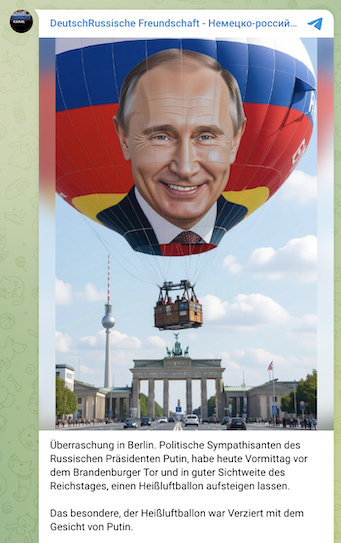

In Sozialen Netzwerken heißt es, ein Bild zeige einen Heißluftballon mit dem Antlitz Wladimir Putins, der über dem Brandenburger Tor in Berlin aufgestiegen sei. Obwohl das Bild offensichtlich mit KI erstellt wurde, verbreitet sich die Behauptung weiter.

„Sympathisanten des russischen Präsidenten Putin haben heute Vormittag vor dem Brandenburger Tor und in guter Sichtweite des Reichstages einen Heißluftballon aufsteigen lassen“, heißt es in einem Beitrag des X-Accounts „Christian Abel AfD“ vom 8. Oktober 2025 mit knapp hunderttausend Aufrufen. Auf einem Bild dazu ist auf dem Ballon das Gesicht des russischen Machthabers Putin zu sehen.

Ein Kandidat mit dem Namen Christian Abel trat 2025 für die Partei bei der Bürgerschaftswahl in Hamburg an. Es ist aber unklar, ob der Account dem gleichnamigen Politiker gehört. Die AfD Hamburg-Wandsbeck ließ eine Anfrage von CORRECTIV.Faktencheck unbeantwortet.

Doch das Bild ist offensichtlich mit einer KI generiert – wie auch viele Nutzerinnen und Nutzer in Kommentaren darunter anmerken. Trotzdem verbreitete sich die Behauptung mit dem Bild auf Facebook, Instagram, X und Telegram.

Woran sich der Fake erkennen lässt, und wieso sich das Bild vermutlich trotzdem weiter verbreitete, erklären wir im Faktencheck.

Unstimmigkeiten entlarven KI-Fake

Bei näherem Betrachten fällt auf, dass das Bild eher einer Illustration als einem Foto ähnelt. Es enthält zudem verdächtig glatte Details, beispielsweise im Gesicht des russischen Machthabers, und Unstimmigkeiten in der Beleuchtung, die in einem echten Foto nicht möglich wären. Auch die Wolken im Hintergrund erscheinen unrealistisch.

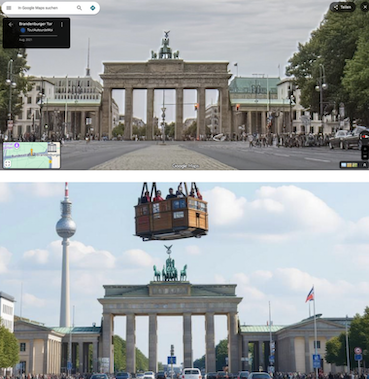

Wen diese Details nicht stutzig gemacht haben, der sollte seine Aufmerksamkeit auf die größeren Fehler im Bild richten: So sehen etwa die Gebäude neben dem Brandenburger Tor anders aus als auf dem KI-Bild. Auch der Fernsehturm wirkt ungewöhnlich hoch. Das bestätigt auch ein direkter Vergleich mit Bildern von Google Maps.

Handelt es sich also nur um ein Symbolbild für einen echten Vorfall? Nein, denn zu der angeblichen Heißluftballonfahrt finden sich auch keine Medienberichte.

Obwohl es sich bei dem KI-Bild also sehr offensichtlich um eine Fälschung handelte, erreichte allein der Beitrag auf X knapp hunderttausend Aufrufe, über 500 Shares und mehr als 2.000 Likes. Wie kann das sein? Vermutlich liegt es auch an den vielen Kommentaren, die auf den offensichtlichen Fake hinweisen. Denn auch durch viele Interaktionen dieser Art stuft der Algorithmus den Beitrag höher ein und zeigt ihn dadurch auch mehr Leuten an

Redigatur: Steffen Kutzner, Gabriele Scherndl