Welche Fake-Videos nach den Angriffen zwischen Israel und dem Iran kursieren

Nicht alle Aufnahmen, die online im Kontext des militärischen Konflikts zwischen Israel und dem Iran verbreitet werden, sind authentisch. Wir haben einige geprüft und mit Experten darüber gesprochen, welche neue Rolle Künstliche Intelligenz dabei spielt.

Nachdem Israel vergangene Woche Atomanlagen und militärische Einrichtungen des Iran bombardierte und ranghohe Militärs tötete, reagiert der Iran mit Raketen- und Drohnenangriffe auf Israel. Die Eskalation zwischen den Ländern wird online von einer Flut an Videos begleitet. Viele davon sind auf Englisch, werden aber Nutzerinnen und Nutzern Sozialer Netzwerke in Deutschland angezeigt. Besonders auffällig: Darunter sind viele KI-generierte Inhalte.

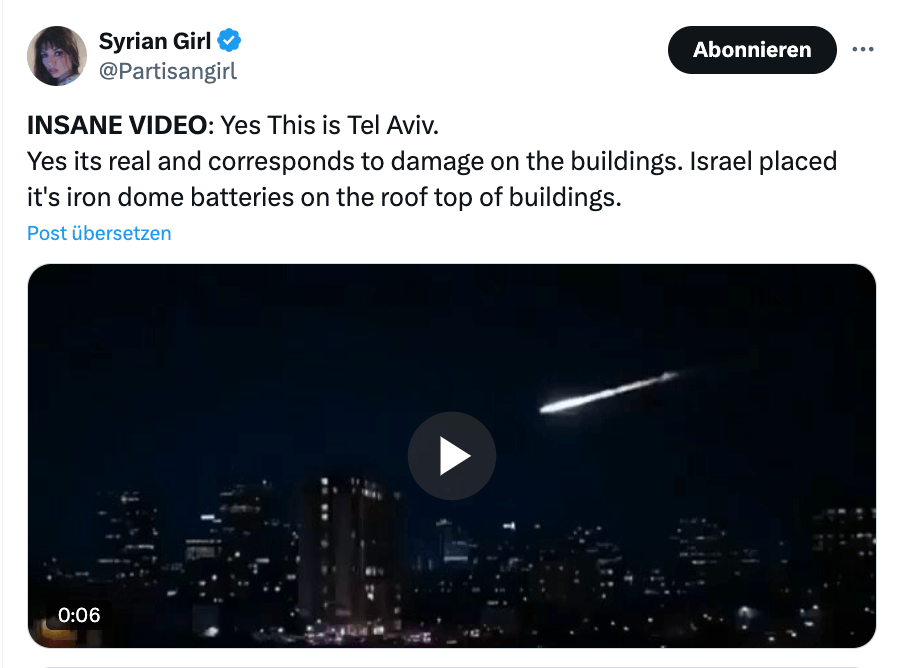

Video von Raketenangriff auf Haus in Tel Aviv ist Fake und KI-generiert

So etwa ein Video, das einen Raketenangriff auf ein Haus in Tel Aviv zeigen soll. Nach dem Einschlag bricht scheinbar ein ganzer Teil des Hauses ab. „Ja, es ist echt und stimmt mit Schäden an den Gebäuden überein“, heißt es in einem X-Beitrag zu dem Video mit fast einer Million Aufrufe.

Der Beitrag enthält einen Hinweis, eine sogenannte Community Note. Darin schreiben Nutzerinnen und Nutzer, dass das Video ursprünglich vom iranischen Staatsmedium Press TV veröffentlicht worden sei. Dort habe ein Wasserzeichen unten rechts im Video auf Veo, den KI-Video-Generator von Google, hingewiesen.

Der Beitrag von Press TV ist nicht mehr online – in dem archivierten Beitrag und anderen Versionen des Videos auf X ist das Wasserzeichen jedoch zu sehen. Das allein ist aber noch kein ausreichender Beleg dafür, dass das Video KI-generiert ist. Valentin Schwind, Professor für Mensch-Computer-Interaktion an der Frankfurt University of Applied Sciences, schreibt uns, ein solches Wasserzeichen könne auch im Nachhinein bei echten Videos eingefügt werden.

Laut Martin Steinebach, Abteilungsleiter für Media Security und IT Forensics am Fraunhofer-Institut für Sichere Informationstechnologie, sieht der Zusammenbruch des Hauses künstlich aus. Außerdem müsse die Aufnahme in geringer Distanz zu dem Gebäude entstanden sein, so der Experte, da Bild und Ton so gut wie synchron seien. Das Video wirkt jedoch optisch so, als sei es aus größerer Entfernung aufgenommen worden.

Ein weiterer von uns kontaktierter Experte ist Hani Farid. Er ist Professor an der UC Berkeley und Mitbegründer und wissenschaftlicher Leiter von GetReal Security, einer Firma, die Lösungen für die Überprüfung und Authentifizierung von Videos und anderen digitalen Inhalten anbietet. Er schreibt, das Video sei aufgrund der Bewegung und Erscheinung „offensichtlich fake“. Aufgrund eines fehlenden unsichtbaren Wasserzeichens, das Google normalerweise hinzufügt, war sich Farid zunächst nicht sicher, ob das Video von Veo stamme. Emmanuelle Saliba, eine von ihm kontaktierte Kollegin, konnte das Video aber schließlich der Google-KI zuordnen.

Auch ein Faktenchecker der BBC und ein israelischer Faktenchecker wiesen auf X darauf hin, dass das Video wahrscheinlich KI-generiert sei. Dafür spreche die Darstellung der Rakete, des Rauchs und der Schäden am Gebäude. Das Material sei einem tatsächlichen Angriff in der Stadt Bat Yam am 15 Juni nachempfunden, bei dem sechs Menschen starben und fast zweihundert verletzt wurden. Auch hier war ein Teil des Gebäudes zusammengebrochen. Aufnahmen des Angriffs in Sozialen Netzwerken sehen jedoch anders als das Video aus.

Tiktok-Video von brennendem israelischen Flugzeug ist ein KI-Fake

Sicher KI-generiert ist dagegen laut allen drei von uns befragten Experten ein Tiktok-Video, das ein brennendes israelisches Flugzeug am Flughafen Ben Gurion zeigen soll. Es hat mehr als acht Millionen Aufrufe und 400.000 Likes.

Martin Steinebach schreibt uns, ein typisches Merkmal von KI-Videos sei, dass wie bei diesem Video im Hintergrund Personen in Objekten verschwinden würden. Außerdem wirke die Steuerklappe des Flugzeugs im Wind, als ob sie aus Stoff sei. Hani Farid schreibt uns, er habe aus mehreren Frames das unsichtbare Wasserzeichen extrahieren können, das beweise, dass das Video von Veo – also dem KI-Video-Generator von Google – stammt.

Zwar ist im Zuge des militärischen Konflikts der Luftraum über dem Nahen Osten gesperrt worden und Flugzeuge blieben am Boden, über einen Angriff auf Flugzeuge am Flughafen Ben Gurion gibt es aber aktuell (Stand: 16. Juni) keine seriösen Medienberichte.

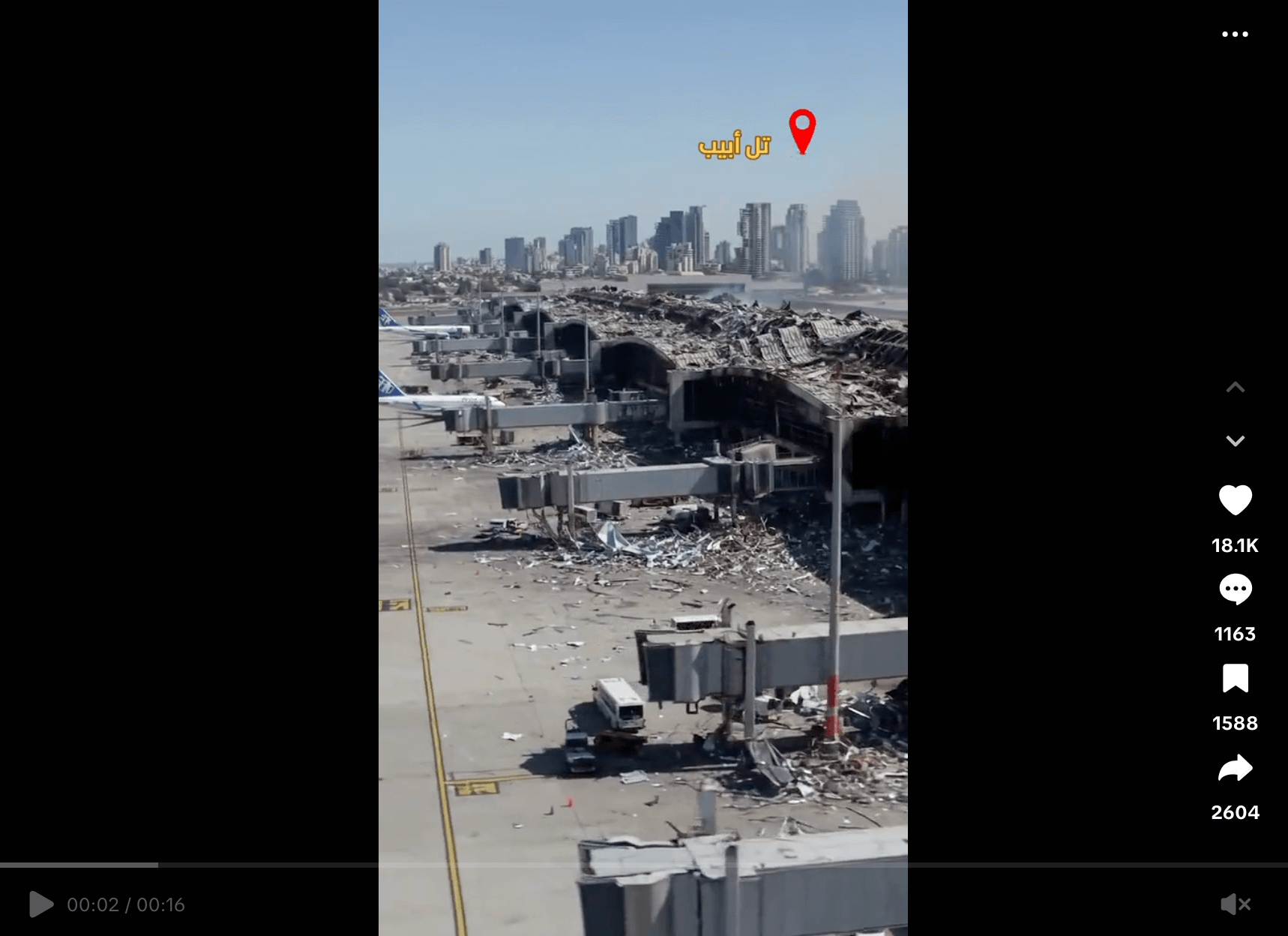

Video von zerstörtem Flughafen ist ebenfalls mit KI erstellt worden

Auch ein weiteres Tiktok-Video mit etwa einer Million Aufrufen zeigt kein authentisches Material: Zu sehen ist ein fast komplett zerstörter Flughafen. Dazu heißt es „Tel Aviv Airport Right Now“ („Flughafen Tel Aviv in diesem Moment“).

Martin Steinebach vom Fraunhofer-Institut für Sichere Informationstechnologie weist darauf hin, dass im Video die Größenverhältnisse zwischen Flugzeugen und Umgebung nicht stimmig seien. Weiterhin sei das Fahrverhalten der Autos seltsam. So ist ab Sekunde acht zu sehen, wie mehrere Autos in Schutthaufen fahren. Hani Farids Analyse ergibt, dass auch dieses Video laut unsichtbaren Wasserzeichen mit Googles KI-Video-Generator Veo erstellt wurde.

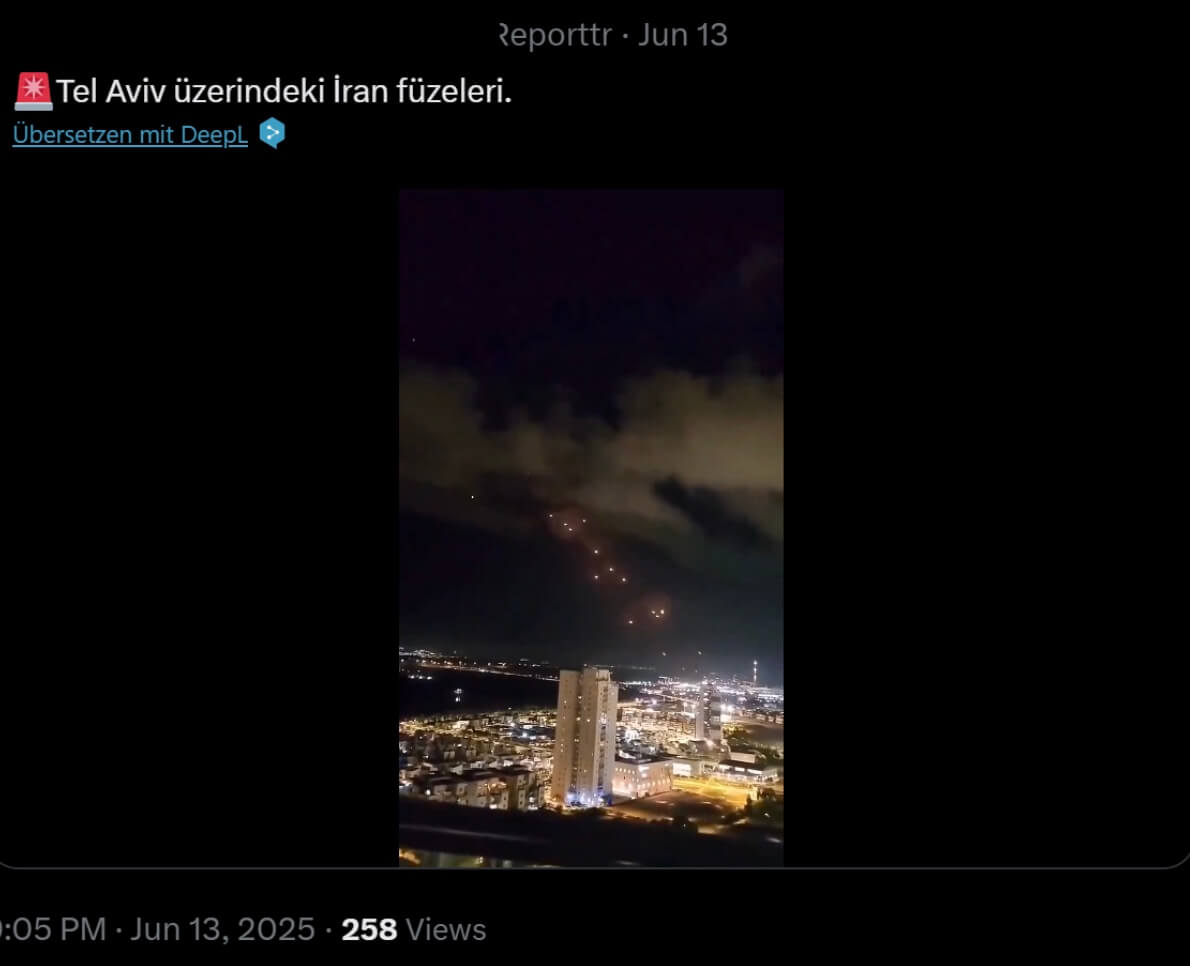

Video von Raketen über Tel Aviv ist echt, aber mehrere Monate alt

Ein Video, das auf Youtube und X kursiert, soll angeblich zeigen, wie iranische Raketen in Tel Aviv einschlagen. Auch das offizielle X-Profil der israelischen Streitkräfte verbreitete die Aufnahme in einem Video-Zusammenschnitt mit der Behauptung, es seien aktuelle Angriffe zu sehen.

Das Video wurde jedoch schon am 1. Oktober 2024 auf Tiktok veröffentlicht. Laut Bildunterschrift zeigt es tatsächlich iranische Raketen, die in Tel Aviv einschlagen, das Video ist auf Tiktok aber inzwischen gelöscht. Auf X findet es sich ebenfalls, veröffentlicht am 9. Oktober 2024, dort mit dem Text: „Der schönste Blickwinkel auf den iranischen Raketenangriff. Ein Besatzer aus Tel Aviv hat diese historischen Bilder aufgenommen.“

Anfang Oktober 2024 gab es tatsächlich einen iranischen Raketenangriff auf Tel Aviv, wie etwa ein Video der Nachrichtenagentur Reuters vom 2. Oktober 2024 zeigt. Auch Al Jazeera und CNN berichteten über die Angriffe.

Videogeneratoren sind inzwischen leichter verfügbar und liefern bessere Qualität

Auffällig ist bei den aktuell kursierenden Fakes: Im Vergleich zu vergangenen Konflikten scheinen mehr KI-generierte Videos in Sozialen Netzwerken zu kursieren.

Valentin Schwind von der Frankfurt University of Applied Sciences, schreibt uns, es gebe einen klaren Trend „hin zur Nutzung von immer mehr KI-generierten Videomaterial für propagandistische Zwecke und natürlich Fake News“.

Martin Steinebach vom Fraunhofer Institut für Sichere Informationstechnologie führt das auf die bessere Verfügbarkeit und Qualität von Videogeneratoren zurück. Es sei für Anwenderinnen und Anwender „leicht geworden, entsprechende Inhalte zu verbreiten“ . Zusammen mit der gestiegenen Bedeutung von Videodiensten wie Tiktok als Informationsquelle, sei das „ein offensichtlicher Nährboden für die Verbreitung entsprechender Fälschungen“.

Valentin Schwind gibt darüber hinaus zu bedenken: Videos mit vielen Klicks verleiten über die Algorithmen der Sozialen Netzwerke zum Ansehen weiterer Videos. „Videos werden also KI-generiert, um allein durch provozierende Inhalte oder die pure Masse Klicks auf andere Videos oder Profile zu ziehen“, schreibt Schwind. Dort werde dann auf die eigentliche Nachricht oder Ideologie verwiesen. Die KI-generierten Inhalte seien daher häufig „eine schnelle Eintrittskarte in die Informationsblase“.

Alle Faktenchecks zu Falschmeldungen und Gerüchten zum Krieg im Nahen Osten finden Sie hier.

Redigatur: Max Bernhard, Matthias Bau