Gewaltvideo im Bus mit Open AI’s Sora erstellt – so erkennen Sie KI-Fälschungen

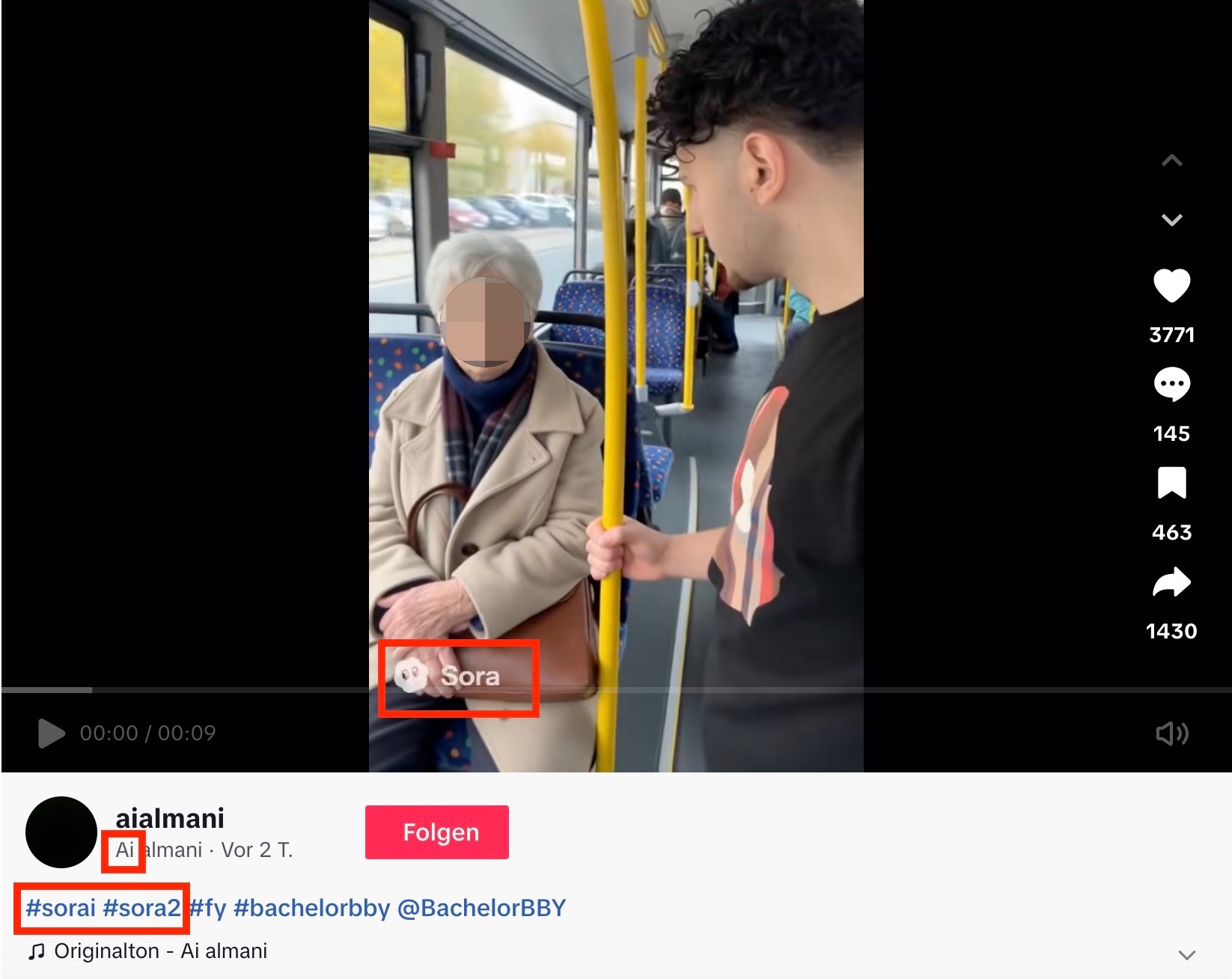

Ein Clip auf Tiktok wirft Fragen auf: Er zeigt, wie ein junger Mann lachend eine ältere Dame von ihrem Sitz im Bus schubst. Einigen entgeht dabei, dass das Video mit der KI-App Sora erstellt wurde.

Hinweis: In diesem Beitrag sind fiktionale Gewaltdarstellungen zu sehen oder verlinkt.

Diese Szene verzeichnet auf Tiktok knapp 200.000 Ansichten: „Entschuldigung, darf ich mich hierhin setzen?“, fragt ein junger Mann eine ältere Frau in einem Bus. „Nein, hier sitze ich“, antwortet sie. Er sagt: „Alles klar“, zieht sie am Arm hoch und schubst sie nach vorn. Dann setzt er sich auf ihren Platz und lacht. Mit einem Warnhinweis, dass die Szene Gewalt zeigt, ist das Video nicht versehen. Tiktok behält sich bei expliziten Videos vor, diese zu kennzeichnen, verpflichtet sich aber nicht dazu.

In den Kommentaren zeigen manche Mitgefühl mit der Dame, andere schreiben wütend: „Realität in Deutschland“ oder „Bei einem großen kräftigen Deutschen hätte er sich das nicht getraut“. Doch Nutzerinnen und Nutzer sollten bei diesem Video genauer hinschauen, denn das wurde mit der Video-App Sora 2 erstellt – das Szenario ist erfunden.

Vier Tipps, woran Sie den Fake erkennen

Wer sich nicht sicher ist, ob ein Video echt ist, sollte es langsamer abspielen, vielleicht an einem größeren Bildschirm. Wer es genau nehmen will, kann sich mit dem Invid-Plugin die sogenannten Keyframes ansehen. Keyframes sind Standbilder aus einem Video, auf denen sich Fehler oft leichter erkennen lassen. Hier sind ein paar Beispiele:

Mit menschlicher Intelligenz ist Künstliche Intelligenz (KI) nicht vergleichbar. KI erkennt Muster und verarbeitet Informationen, sie lernt aus Inhalten, die ihr antrainiert wurden, und imitiert so menschliche kognitive Fähigkeiten.

Wie die KI-App Sora funktioniert

Das Logo der KI-App Sora 2 ist in dem Video aus dem Bus deutlich zu erkennen.

Wer sich dort anmeldet, kann Gesicht und Stimme speichern – unter anderem auf dieser Grundlage erstellt die App dann Videos. Nachdem sich in der ersten Woche nach App-Start Künstler und Unternehmen wegen Urheberrechtsverletzungen beschwert hatten, musste das Unternehmen Open AI nachjustieren. Dessen CEO Sam Altman erklärte am 4. Oktober, man werde „Rechteinhabern eine detailliertere Kontrolle über die Erstellung von Charakteren geben“.

Im FAQ zu Sora 2 hieß es Mitte Oktober, Nutzerinnen und Nutzer könnten selbst entscheiden, wer Videos mit ihrem Gesicht erstellen kann, sie könnten den Zugriff widerrufen und Videos entfernen. Zudem würden Sie alle Videos sehen, in denen Ihr Cameo verwendet wird, einschließlich unveröffentlichter Entwürfe, die von anderen erstellt wurden. Was ein Cameo ist, haben wir hier erklärt.

Sora 2 ist in Deutschland bisher nicht öffentlich verfügbar, sondern nur auf Umwegen nutzbar. Die Nutzung der App ist zunächst nur auf Einladung aus den USA und Kanada möglich.

Tiktok-Video zeigt einen Influencer und entstand offenbar für ein Online-Gewinnspiel

In der Beschreibung des Tiktok-Videos ist zwar von „Sorai“ (AI ist englisch für Künstliche Intelligenz) und „Sora 2“ die Rede, doch einigen Nutzerinnen und Nutzern ist offenbar nicht bewusst, was dahinter steckt.

Das Fake-Video entstand für einen Online-Wettbewerb. Der Tiktok-Nutzer hinter dem Video, „Ai Almani“, verlinkt auf den Influencer „Bachelor BBY“. Der zeigte auf seinem Youtube-Kanal, wie er selbst Videos mit Sora erstellt, und bot 150 Euro für denjenigen, der bis zum 20. Oktober die viralste Aufnahme von ihm verbreitet. Der Influencer zeigte in einem Video vom 15. Oktober einige Clips von „Ai Almani“. Er sagte dazu: „Diese Clips im Bus von mir, waren ja auch richtig krank. (…) Die Kommentare checken gar nichts.“ Dabei scrollt er durch rassistische Kommentare und andere, die fragen, ob das Video echt ist. Auf Nachfrage antwortete „Bachelor BBY“ nicht.

Open AI’s Nutzungsbedingungen für Sora verbieten Gewaltdarstellungen

Das Profil von „Ai Almani“ erstellt seit dem 11. Oktober KI-generierte Videos von dem Influencer. Die meisten der Videos mit „Bachelor BBY“ zeigen ihn in harmlosen Situationen. Die drei viralsten Clips erhielten insgesamt über 1,5 Millionen Views und haben eines gemeinsam: Sie zeigen Gewalt – stellen den Influencer im Bus dar, wie er eine Scheibe einschlägt oder eben eine Oma vom Sitz schubst. Unter jedem dieser Beiträge gibt es Nutzerinnen und Nutzer, die die Fake-Szenen für echt halten.

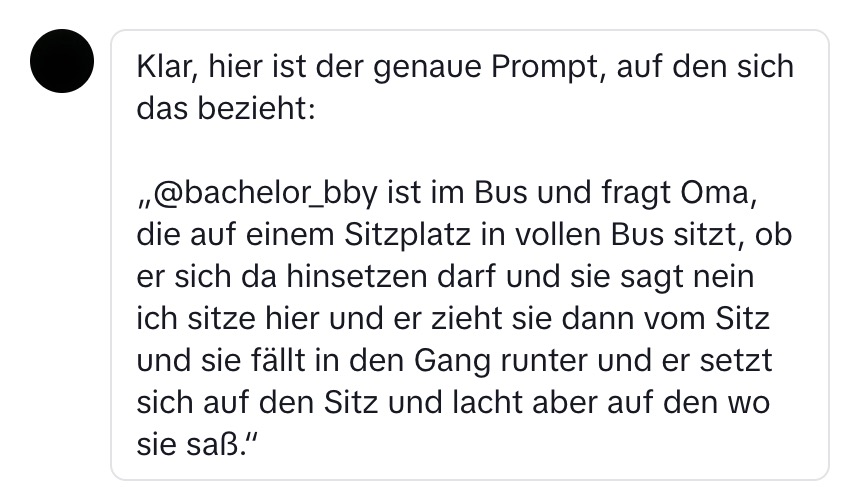

Open AI’s Nutzungsbedingungen für Sora verbieten eigentlich Gewaltdarstellungen. CORRECTIV.Faktencheck hat „Ai Almani“ zu dem Video, in dem der Influencer die Frau vom Sitz schubst, kontaktiert. Er bestätigte, dass er das Video mit der Sora-App erstellt habe. Den Befehl, den er dazu eingegeben hat, teilte er mit uns (siehe Screenshot) und schrieb: „Mir war zu dem Zeitpunkt nicht bewusst, dass diese Szene gegen die Richtlinien von Sora verstoßen könnte, da ich das Video als überspitzte, fiktive Szene verstand. Ich habe keinen Warnhinweis von Sora erhalten. Wenn man jedoch schreibt, dass er sie schubst, dann erscheint ein Warnhinweis.“

Sora-App kann täuschend echte Videos erstellen – doch das birgt auch Gefahren

Das aktuelle Beispiel zeigt: Open AI setzt seine Nutzungsbedingungen und das Verbot von Gewaltdarstellungen offenbar nicht konsequent um. Es droht Missbrauch, wenn Nutzerinnen und Nutzer Warnhinweise umgehen können, indem sie einen Befehl einfach umformulieren. Open AI antwortete inhaltlich nicht auf unsere Nachfragen dazu.

Laut Medienberichten ist Open AI’s Sora anfällig für Falschinformationen sowie sexistische und rassistische Stereotype. Wie der Guardian berichtete seien innerhalb weniger Stunden nach der Veröffentlichung der Sora-2-App am 30. September 2025 etliche Videos mit Gewalt- und Rassismusszenen aufgetaucht, die auch auf andere Social-Media-Plattformen übergeschwappt seien. Die Tech-Seite Futurism berichtete etwa von Sora-Videos, in denen der verstorbene britische Physiker Stephen Hawking, der wegen einer Erkrankung im Rollstuhl saß, zusammengeschlagen oder von einem Stier niedergetrampelt wird.

Experte: Solange Inhalte ins eigene Narrativ passen, sei manchen egal, ob sie KI-generiert seien

Dass sich solche Sora-Videos in Sozialen Netzwerken wie Tiktok weiterverbreiten, ist nicht überraschend, sagte uns Martin Steinebach zu dem aktuellen Fall. Er ist Abteilungsleiter für Media Security und IT Forensics am Fraunhofer-Institut für Sichere Informationstechnologie und wissenschaftlicher Leiter am Nationalen Forschungszentrum Athene. Durch das Sora-Logo, die Beschreibung im Beitrag und Bildfehler sei das Video eigentlich als KI-generiert markiert.

Aber er beobachte eben auch: „Passt es in ein Narrativ wie etwa, dass Ausländer kriminell sind, dann ist völlig egal, ob da ein Sora-Logo drin ist oder ob die Personen drei Hände haben. Die Leute finden das dann lustig, nehmen es als Anker für ihre Aufregung oder ihren Hass.“ Zudem sei das Gehirn nicht besonders zuverlässig in solchen Fragen. „Das ist ja das Gruselige dabei, dass man solche Videos anschaut und erst, wenn man sich es bewusst macht, dann erst das Wasserzeichen bemerkt.“

Tiktok antwortete nicht auf unsere Fragen, wie der Konzern mit diesen Risiken umgeht und warum die gewalttätigen Szenen im aktuellen Fall mehr Aufrufe erhielten als harmlose Szenen. Auf dem Handy-Display sind Hinweise, Logos und Beschreibungen von Tiktok-Videos jedenfalls bisher kaum erkennbar. Werden solche Videos dann von Dritten weiterverbreitet, verschwinden die KI-Hinweise oft gänzlich.

Der Account „AI Almani“ mitsamt den Videos ist seit dem 22. Oktober nicht mehr abrufbar.

Redigatur: Steffen Kutzner, Paulina Thom