Deepfakes zwischen Pornografie und politischer Desinformation – wie groß ist die Gefahr?

Für einen glaubwürdigen Deepfake braucht es nur Zeit und einen Laptop. Die Technologie wird für Betrug, Rachepornos und Propaganda missbraucht. Über ein Problem, mit dem sich nicht nur Franziska Giffey beschäftigen muss.

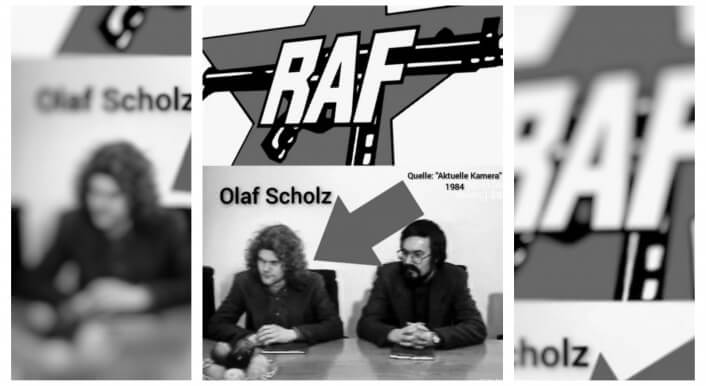

Hätten Sie den Fake erkannt? Schmale Augen, breite Nasenspitze und lichtes Haupthaar. Sie sehen vermeintlich das Gesicht von Bundeskanzler Olaf Scholz, doch das Setting scheint ungewöhnlich: Rechts und links neben ihm sind russische Flaggen – ein erstes Zeichen, dass etwas nicht stimmt. Mit Hilfe einer kostenlosen Software haben wir einen Deepfake erstellt und das Gesicht des russischen Präsidenten Wladimir Putin durch das von Olaf Scholz ersetzt. Wir wollten herausfinden, wie leicht es ist, ein Video zu fälschen. Was kann die Technologie wirklich, die Experten, Behörden und die Politik zunehmend beunruhigt?

Ende 2017 tauchte das Wort Deepfake zum ersten Mal in einem Nachrichtenartikel auf – darin ging es um einen Trend der Pornoindustrie, die Gesichter von Darstellerinnen durch die prominenter Frauen zu ersetzen. Heute, sagen uns verschiedene IT-Experten, sei es sogar möglich, in Echtzeit gefälschte Stimmen, Bilder und Videos zu generieren. Man könnte sich also per Videoanruf mit einer Person unterhalten, die gar nicht echt ist. So wie es der Berliner Bürgermeisterin Franziska Giffey kürzlich passiert ist. Sie glaubte, mit dem Kiewer Bürgermeister Vitali Klitschko zu sprechen. Das Video war eine Fälschung – ob es ein Deepfake war, bleibt bis heute unklar.

Vor ein paar Jahren waren Deepfakes aufgrund ihrer schlechten Qualität einfach zu erkennen, doch die Technologie entwickelt sich rasant weiter. „Hätte uns jemand gesagt, dass Deepfakes eine Qualität haben, wie wir sie heute vorfinden, hätten wir daran selber nicht geglaubt“, sagt uns der IT-Experte Thomas Endres, der gemeinsam mit einem Kollegen eine Software für Deepfakes entwickelt hat.

Auch online gibt es inzwischen zahlreiche frei verfügbare Tools zum Erstellen von Deepfakes. Jeder, der Soziale Netzwerke benutzt, ist täglich damit konfrontiert. Auf Snapchat, Instagram oder Tiktok lassen Filter die Haut glatter oder Wimpern länger erscheinen. Wer will, kann sogar mit der Stimme eines Promis sprechen. Meist dient das nur Unterhaltungszwecken, doch der Weg zur missbräuchlichen Nutzung von Deepfake-Software ist kurz.

Wie groß ist die Gefahr, die von Deepfakes ausgeht? Um das herauszufinden, haben wir die Geschichte dieser Technologie recherchiert, mit den russischen Komikern gesprochen, die Franziska Giffey täuschten und selbst ein Deepfake-Video produziert.

Hier klicken für eine Definition von Deepfakes.

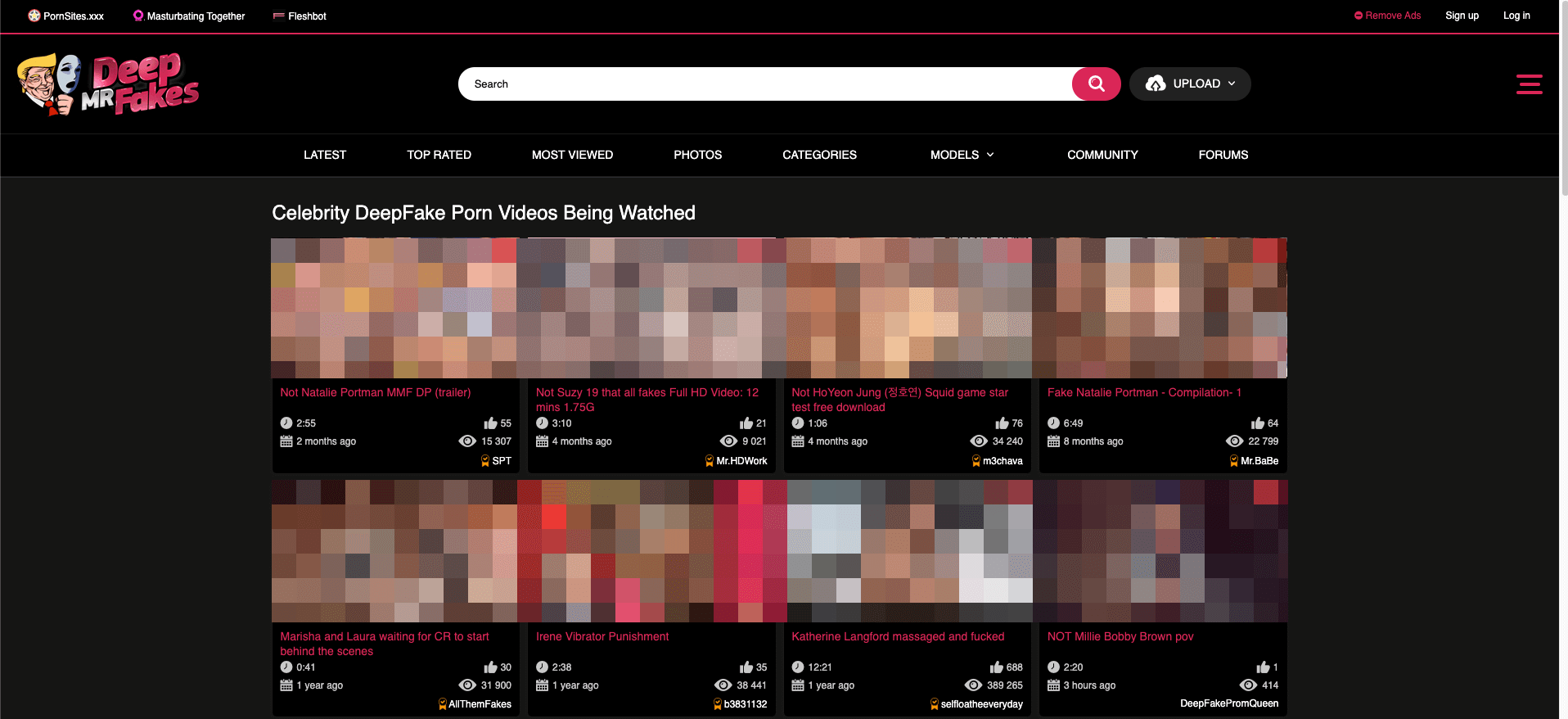

Das größte Deepfake-Forum ist eine Pornoseite

Wer Deepfakes verstehen will, kommt an Pornografie nicht vorbei. 2019 ergab eine Untersuchung des britischen Cybersicherheitsunternehmens Deeptrace Labs, dass 96 Prozent aller Deepfake-Videos pornografische Inhalte betreffen. Meist wird das Gesicht einer Person ohne ihre Zustimmung in ein Video montiert.

Auf der Seite der beliebtesten Deepfake-Software ist das Forum „MrDeepfakes“ verlinkt, welches sich selbst als die größte aktive Diskussionsplattform zum Thema bezeichnet. Dort wird vor allem über eins diskutiert – wie man gute Fake-Pornos erstellt.

November 2018

Die indische Journalistin Rana Ayyub macht öffentlich, dass ihr Gesicht mittels Deepfake in ein Pornovideo montiert wurde. Es war mutmaßlich die Rache für ihren öffentlichen Einsatz für Gerechtigkeit nach derVergewaltigung eines jungen Mädchens.

„MrDeepfakes“ ist nicht nur ein Forum, sondern auch Videoplattform. Mit dem Unterschied, dass es hier keine Videos mit Beauty-Tutorials gibt oder Typen, die Minecraft zocken – sondern Pornos. Diese sind ausnahmslos Fälschungen, wie ein Hinweis gleich beim Öffnen der Webseite erklärt. Schauspielerinnen wie Natalie Portman, Keira Knightley, oder die Sängerin Billy Eilish: Ihre Gesichter findet man dort in Szenen, die im Original professionelle Pornodarstellerinnen zeigen.

Deutsche TV-Moderatorinnen von gefälschten Pornovideos betroffen

Im Forum tauschen sich Nutzer aus, besprechen, wie sie ihre Deepfakes verbessern können. Sie suchen gezielt nach Pornostars, die Schauspielerinnen ähneln, um glaubwürdige Fälschungen zu erstellen. Sie teilen ihre Erfolge, geben sich Tipps, feuern sich an. Manche bitten auch andere Nutzer darum, Deepfakes für sie zu erstellen.

„Ich finde, sie ist eine der heißesten TV-Moderatorinnen und ist definitiv für tolle Fakes geeignet“, schreibt ein Nutzer im Forum. Dazu schickt er das Video einer deutschen Moderatorin, die passende Porno-Darstellerin hat er schon ausgesucht. Auch für eine weitere deutsche Moderatorin gibt es eine ähnliche Anfrage. Der Nutzer ist sogar bereit, Geld zu zahlen, damit jemand einen Porno-Deepfake von ihr erstellt – dafür gibt es im Forum einen gesonderten Bereich. Um die Frauen zu schützen, veröffentlichen wir ihre Namen hier nicht. Allein im Juli gab es im Forum 16 Anfragen für Fälschungen gegen Bezahlung.

Die zweifelhafte Moral der Nutzer des Deepfake-Forums

Im Forum der Pornoseite „MrDeepfakes“ haben sich die Nutzer seltsame Regeln auferlegt: Nicht alle Menschen dürfen für Fälschungen benutzt werden. Die zentrale Richtlinie lautet: Die Personen, deren Gesichter für Fakes benutzt werden, müssen prominent sein, also Schauspielerinnen, Influencer, in der Politik oder Wirtschaft tätig. Sie müssen mindestens 100.000 Follower auf Youtube, Twitter, Twitch oder Instagram haben – oder 200.000 auf Tiktok.

Wenn eine Person ausreichend bekannt ist, nehmen sich die Forum-Nutzer das Recht heraus, ihre Identität zu missbrauchen.

August 2020

Eine Schauspielagentin aus Berlin macht öffentlich, dass sie einer Fälschung aufgesessen ist. Ein angeblicher Vin Diesel behauptete, sich bei ihr für ihre Unterstützung als Fan bedanken zu wollen. Irgendwann gab es, so berichtet die Frau, Liebesbekundungen und gemeinsame Zukunftspläne. Der vermeintliche Weltstar brachte die Berlinerin dazu, ihm mehr als 5.000 Euro zu überweisen. Am Ende stellte sich Vin Diesel als Fake heraus.

Abseits von Pornografie werden Deepfakes genutzt, um falsche Informationen zu verbreiten, Menschen zu erpressen, zu diffamieren, zu manipulieren und zu täuschen.

März 2019

Der Vorstandsvorsitzende eines britischen Energieunternehmens glaubte, mit seinem Chef, dem Geschäftsführer der deutschen Muttergesellschaft, zu telefonieren. Dieser forderte ihn auf, in einer dringenden Angelegenheit umgerechnet 220.000 Euro an einen ungarischen Lieferanten zu überweisen. Dahinter steckten Kriminelle, die die Stimme des Geschäftsführers mit Hilfe von Künstlicher Intelligenz fälschten.

Auch Politikerinnen und Politiker wurden immer wieder Opfer solcher Fälschungen, zuletzt im Juni mehrere europäische Bürgermeisterinnen und Bürgermeister.

Ein falscher Vitali Klitschko und viele getäuschte Bürgermeisterinnen und Bürgermeister

„Allem Anschein nach handelt es sich um Deepfake“, schrieb die Berliner Staatskanzlei am 24. Juni auf Twitter. Stunden zuvor glaubte Bürgermeisterin Franziska Giffey ein Videogespräch mit dem Kiewer Bürgermeister Vitali Klitschko geführt zu haben. „Was wir mit Sicherheit sagen können: Dass es eine Manipulation war“, sagte Giffey vier Tage später bei einer Pressekonferenz. Ob es wirklich ein Deepfake war, da war sie sich inzwischen offenbar selbst nicht mehr so sicher.

Giffey war nicht die einzige, die sich täuschen ließ. Der falsche Klitschko rief Medienberichten zufolge auch in Budapest, Madrid, Warschau und Wien an und sprach mit EU-Innenkommissarin Ylva Johansson. Giffey schöpfte schon bei dem Gespräch Verdacht. Mehrere Fragen seien irritierend gewesen, sagte die Berliner Bürgermeisterin. Etwa, ob die ukrainische Polizei nach Berlin komme könne, um die dorthin geflüchteten kampffähigen Männer wieder für den Krieg einzusammeln. Das und weitere Fragen hätten Giffey und ihr Team irritiert, schreibt uns ein Sprecher der Berliner Senatskanzlei. Als man kurzzeitig den Ton stummgeschaltet habe, um die seltsamen Fragen zu besprechen, habe der gefälschte Klitschko aufgelegt.

Andere hatten weniger Glück. Der Wiener Bürgermeister Michael Ludwig erfuhr erst nach dem Telefonat, dass er hereingelegt wurde. Er nannte den Fake auf Twitter einen „schweren Fall von Cyberkriminalität“. Giffey bezeichnete die Fälschung gar als „Mittel der modernen Kriegsführung“. Der echte Vitali Klitschko sagte, es müsse dringend ermittelt werden, wer dahinter stecke.

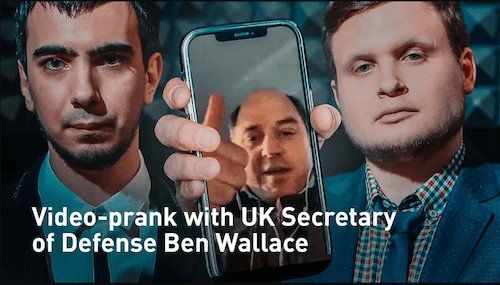

Russische Komiker bekennen sich zu Fake-Gesprächen mit Giffey und Co.

Wenige Tage nach dem Gespräch Giffeys bekannten sich zwei russische Komiker in einem Interview mit Daniel Laufer, Journalist beim ARD-Politikmagazin „Kontraste“, zu den Fakes. Ihre Künstlernamen sind Vovan und Lexus, eigentlich heißen sie Vladimir Kuznetsov und Alexey Stolyarov. Sie haben ihre ganze Karriere auf „Pranks“, also „Streichen“, aufgebaut, wie sie es nennen. Ihre Opfer sind prominent, zu ihnen gehören beispielsweise der Schriftsteller Stephen King oder der britischen Verteidigungsminister Ben Wallace. Auch der französische Präsident Emmanuel Macron zählt zu den Opfern der Komiker. Ihn legten sie 2019 mit einer Fälschung des ukrainischen Präsidenten Wolodymyr Selenskyj rein.

„Ich gehe davon aus, dass sie das waren“, sagte uns der „Kontraste“-Journalist Daniel Laufer auf die Frage, für wie plausibel er das Bekenntnis der Russen zum Klitschko-Fake hält. Vovan und Lexus hätten schon Aufnahmen aus den Telefonaten mit EU-Kommissarin Johansson veröffentlicht, als diese selbst noch nicht gewusst habe, dass sie getäuscht wurde.

Auf Anfrage von CORRECTIV.Faktencheck bekräftigten die Komiker ihre Aussagen. Sie kündigten uns am 3. August einen Ausstrahlungstermin für ihre Sendung zum Giffey-Telefonat an: den 11. August. „Sie werden die Beweise bald sehen“, schreiben sie uns. Tatsächlich erschien an dem Tag ein rund neun Minuten langes Video, das Giffey bei dem Videotelefonat zeigt. Dass Vovan und Lexus hinter dem Telefonat stecken, ist dadurch belegt. Doch wie erstellten sie die Fälschung? Einen Deepfake hätten sie dafür nicht genutzt, so die Komiker.

Vovan und Lexus: „Wir nutzen keine Deepfakes, wir haben unsere eigenen Geheimnisse“

Eine Analyse von Laufer legt ebenfalls nahe, dass die Komiker eine andere Methode für die Fälschung benutzt haben. Laufer hat Fotos aus dem Gespräch von Giffey mit einem älteren Video von Klitschko verglichen. Er stellte fest, dass die aktuellen Fotos, die die Staatskanzlei veröffentlichte, identisch mit einzelnen Aufnahmen aus dem alten Video sind. Sein Verdacht: Die Fälscher schnitten kleine Sequenzen vor – etwa von einem lächelnden, schweigenden oder nickenden Klitschko – und spielten diese live in dem Gespräch mit Giffey an der passenden Stelle ab. „Wenn die Übergänge eben nicht ganz gepasst haben, war das vielleicht dadurch kaschiert, dass es im Call kleine Ruckler gab“, sagte uns Laufer. „Das ist meine Vermutung, und das wäre immer noch ziemlich gut gemacht. Aber es ist nicht die technologische Herangehensweise eines Deepfakes.“ Eher ein sogenannter Cheap-Fake, glaubt der Journalist.

Die von uns befragten IT-Experten halten diese Theorie für durchaus plausibel. Martin Steinebach, Professor und Leiter der Abteilung Mediensicherheit und IT-Forensik am Fraunhofer-Institut für Sichere Informationstechnologie sagt, derselbe Effekt sei technologisch auch mit einem Live-Deepfake möglich. Endgültige Sicherheit könne nur eine Analyse des Videogesprächs selbst bringen.

In der Sendung von Vovan und Lexus vom 11. August sind nur die Aufnahmen von Franziska Giffey zu sehen, den gefälschten Klitschko zeigen die Komiker nicht. Eine weitere Analyse ist daher nicht möglich und die Frage, ob es sich um einen Deepfake handelt, lässt sich weiterhin nicht beantworten. Uns schrieben die Komiker lediglich: „Wir haben unsere eigenen Geheimnisse. Manchmal nutzen wir eine ähnliche Person, verkleiden und schminken sie.“

Doch warum machen Vovan und Lexus das? Sie selbst sagen, sie wollten mit der Veröffentlichung ihrer Pranks zeigen, wie echte Politik funktioniere. „Es ist interessant zu zeigen, welche Lügen sich hinter langweiligen Pressemitteilungen und beschönigten Interviews in kontrollierten Medien verbergen“, schreiben sie uns. „Prank-Journalismus“ nennen sie das. Auffällig ist, dass die Streiche der zwei Russen oft auf die Ukraine abzielen. So sprach der gefälschte Klitschko mit Giffey über den Ukraine-Krieg, und den Schriftsteller Stephen King fragten sie, was er von dem umstrittenen ukrainischen Politiker Stepan Bandera halte.

Schon 2016 gab es den Vorwurf, das Duo arbeite im Sinne des Kreml

Auf wessen Kosten die Pranks gehen, lässt Zweifel an der journalistischen Unabhängigkeit von Vovan und Lexus aufkommen. Nach Recherchen von Kontraste sind ihre Videos „stets im Sinne von Putins Propaganda“. Die britische Zeitung Guardian erhob schon 2016 ähnliche Vorwürfe, nachdem das Duo Elton John getäuscht und sich dabei als Wladimir Putin ausgegeben habe. Vovan und Lexus sind zudem nach eigenen Angaben seit April 2022 sogenannte „Rutube-Botschafter“, sie bekommen Geld von der Plattform, wie sie uns auf Anfrage bestätigen. Rutube ist eine russische Version von Youtube. Die Plattform gehört Gazprom-Media, einer Gazprom-Tochter, und damit einem staatlichen russischen Unternehmen.

Auf Anfrage bestreiten Vovan und Lexus, im Sinne des russischen Staates zu agieren. „Das ist eine sehr dumme und unprofessionelle Anschuldigung. Wären wir Lehrer an einer öffentlichen Schule, würden wir auch Geld vom Kreml bekommen“, schreiben sie uns.

Es wird immer leichter, einen Deepfake zu erstellen

Digitale Inhalte zu manipulieren, ist bereits seit vielen Jahren möglich, war aber lange mit einem sehr großen technischen und zeitlichen Aufwand verbunden. Das hat sich inzwischen verändert. Wie schnell sich die Technologie weiterentwickelt, erklärte uns Matthias Neu, Deepfake-Experte beim Bundesamt für Sicherheit in der Informationstechnik (BSI). „Im Bereich von Face-Swapping können inzwischen zwei bis drei Minuten Videomaterial ausreichen. Und vor einigen Jahren waren für eine glaubhafte Audiofälschung noch rund 20 Stunden Material notwendig. Inzwischen können auch dafür wenige Minuten oder gar Sekunden genügen“.

Hier klicken, um verschiedene Formen von Deepfakes kennenzulernen.

In wenigen Jahren könnte schon ein Foto als Ausgangsmaterial für ein überzeugendes Deepfake-Video reichen

Selbst Experten sind von der Entwicklung überrascht. Thomas Endres und Martin Förtsch, die bei dem IT-Beratungsunternehmen TNG arbeiten fingen im Jahr 2018 an, ihre eigene Deepfake-Software zu entwickeln. Mittlerweile, so die IT-Experten, könnten sie damit täuschend echte Live-Fakes produzieren. Sie halten regelmäßig Vorträge zum Thema, geben Interviews, erklären die Technologie und ihre Möglichkeiten.

„Den Stand, den wir jetzt qualitativ bei Deepfakes haben, hatten wir 2019 eigentlich erst für 2025 erwartet. Wir haben damals von fünf bis zehn Jahren geredet, tatsächlich waren es nur zwei“, sagt Martin Förtsch. Auch Echtzeit-Deepfakes seien nicht weit von fotorealistischen Ergebnissen entfernt. In wenigen Jahren könnte es soweit sein, schätzen die Experten.

Juni 2019

Ein angebliches Video von Facebook CEO Mark Zuckerberg taucht auf. Darin sagt er: „Derjenige, der die Daten kontrolliert, kontrolliert auch die Zukunft.“ Das Video war einer der ersten Deepfakes, der eine öffentliche Debatte auslöste.

Auch Martin Steinebach geht von einer rasanten Weiterentwicklung aus. Das Erkennen von Deepfakes gehört zu seinem Job. „Ich befürchte, wir sind relativ nah dran, dass schon das Profilfoto von Facebook für einen guten Deepfake ausreicht“, sagt er. Die ersten Versuche gebe es schon: „Es kann sein, dass das noch ein Jahr oder zwei Jahre dauert. Aber ich würde mich wundern, wenn es viel länger dauern würde.“

Wie groß die Gefahr durch Deepfakes ist, hängt davon ab, wie viel technisches Verständnis und Ressourcen nötig sind, um sie zu produzieren. Wir haben uns gefragt, wie einfach es bereits heute ist, als Laie einen glaubwürdigen Deepfake zu erstellen – und haben es ausprobiert.

Unser Experiment: Ein Tag bis zum ersten Deepfake

Programmierkenntnisse sind für das Erstellen eines Deepfakes nicht nötig, ebenso wenig ein besonders leistungsstarker Computer. Wir haben unsere Tests mit einer kostenfreien Software und einem rund 700 Euro teuren Laptop durchgeführt.

Unser erster Versuch zeigt, dass eine gute Fälschung bei der Suche nach passenden Originalaufnahmen beginnt. „Die Frage für einen guten Deepfake ist: Wie gut ist das Ausgangsmaterial?“, sagt Martin Steinebach. „Sagen wir mal, ich möchte sehen, wie es wäre, wenn Arnold Schwarzenegger Rambo gespielt hätte und nicht Sylvester Stalone. Vielleicht hat man von Schwarzenegger aber nur Fotos vom roten Teppich mit starker Ausleuchtung und die Rambo-Szene ist im halbdunklen Dschungel. Das wird nicht besonders gut aussehen.“

Als Vorlage für unseren ersten Deepfake dienten die Gesichter von Olaf Scholz und Christoph Maria Herbst, dem Schauspieler von Stromberg. Wir haben versucht, das Gesicht von Scholz in eine Szene der Serie „Stromberg“ einzusetzen. Als Rohmaterial nutzten wir Aufnahmen von Scholz aus einer Pressekonferenz. Dabei schaut der Bundeskanzler fast nur nach vorne, lächelt kaum und bewegt seinen Kopf wenig. Die „Stromberg“-Szene hingegen ist deutlich dynamischer – der Schauspieler dreht seinen Kopf nach links und rechts, grinst und macht Grimassen. An manchen Stellen findet die Software deswegen kein passendes Gesicht, und die „Scholz-Maske“ verschwindet. Das Ergebnis:

Besser lief der Versuch, die Gesichter von Olaf Scholz und Wladimir Putin auszutauschen. Von beiden Männern ist im Netz vergleichbares Videomaterial zu finden, etwa aus Pressekonferenzen. Zwei solcher Videos haben wir heruntergeladen. Rund 30 Stunden rechnete die Software für diesen Deepfake:

Bei unserem Test haben wir den einfachsten und schnellsten Algorithmus für das Trainieren der Gesichter ausgewählt, die Software bietet jedoch auch andere Möglichkeiten. Zudem haben wir in allen Fällen die vorprogrammierten Systemeinstellungen der Software übernommen. Wer sich auskennt, kann die Einstellungen verändern und so ein besseres Ergebnis erzielen.

Die Tests zeigen: Mit ein bisschen Zeit und einem herkömmlichen Laptop ist es möglich, relativ überzeugende Deepfakes zu erstellen.

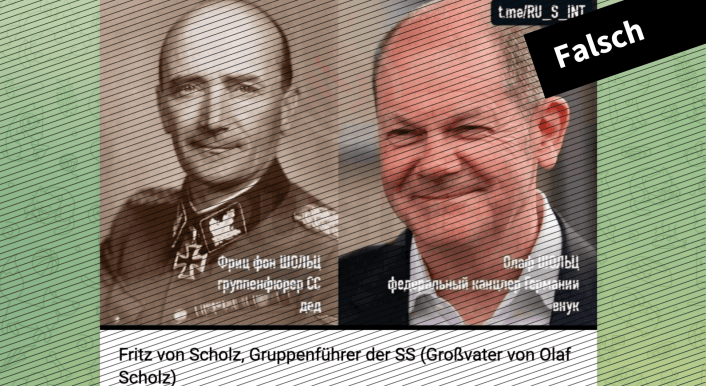

Wenn Politiker belastendes Material als Deepfake abtun – obwohl es echt ist

Expertinnen und Experten warnen regelmäßig vor Deepfakes, immer wieder ist das Thema in der medialen Berichterstattung. Doch das kann auch zu einer verzerrten Wahrnehmung der Problematik führen – und dazu, dass Deepfakes als Ausrede genutzt werden.

„Der größte Schaden, den Deepfakes frühzeitig verursacht haben, ist dieses sogenannte Liars Dividend“, sagt Martin Steinebach. Es habe Fälle gegeben, als entlarvende Inhalte über politische Affären ans Licht gekommen seien und die Betroffenen behauptet hätten, das Material sei nicht echt, es handle sich um einen Deepfake. Als Beispiel nennt er etwa den Fall des damaligen Wirtschaftsministers von Malaysia, Mohamed Azmin Ali. Von ihm war 2019 ein Sexvideo mit einem anderen Mann aufgetaucht. Der Politiker bestritt, dass er darin zu sehen sei und bezeichnete es als Deepfake. Expertinnen und Experten hielten das Video hingegen für echt.

März 2021

Medien und die Öffentlichkeit in Myanmar hielten das Video eines inhaftierten Politikers, der ein Geständnis über Korruption ablegte, für eine Fälschung. Der Grund: Stimme und Gesicht des Gefangenen wirkten verzerrt. Doch das Video war mutmaßlich echt – auch wenn das Geständnis möglicherweise erzwungen war.

Sam Gregory ist Technologieexperte und Programmdirektor von Witness, einer Organisation, die nach eigenen Angaben Menschen hilft, Videos und Technologie zum Schutz und zur Verteidigung der Menschenrechte einzusetzen. Sie verfolgt die Entwicklung und den Einsatz von Deepfakes und anderen neuen Formen der Desinformation auf der ganzen Welt. Auch Gregory warnt: „Immer wieder behaupten Menschen vor dem Hintergrund von Deepfakes, etwas sei gefälscht, obwohl das gar nicht stimmt. Wir haben in manchen Ländern beobachtet, wie das auf der obersten politischen Ebene als rhetorische Strategie genutzt wird.“

Manchmal verbreitet sich schnell die Behauptung, etwas sei ein Deepfake – sei es aus böswilligen Gründen oder weil Menschen nicht glauben wollen, dass etwas wahr ist. Gregory meint: „Oft glauben Menschen heutzutage nicht, dass Fakten Fakten sind. Es ist viel einfacher zu sagen: Naja, eigentlich ist das eine Fälschung.“ Je besser die Fälschungen werden, desto eher können echte Bilder und Videos als Fakes abgetan werden.

März 2022

Andere Fälschungen sind hingegen leicht zu erkennen. Kurz nach Beginn des Kriegs tauchte ein Video auf, das angeblich den ukrainischen Präsidenten Wolodymyr Selenskyj zeigt. Der gefälschte Selenskyj sagt darin, die ukrainische Armee sei gescheitert und das Land solle aufgeben.

Die beste Schutzmaßnahme vor Fakes ist der menschliche Verstand

Deepfakes seien meist daran zu erkennen, dass sie für verdächtiges Verhalten genutzt würden, sagt IT-Experte Thomas Endres. Erzählt eine Person in einem Video etwas Unglaubwürdiges? Klingt die Stimme anders, will die Person etwas haben, Geld zum Beispiel? Das wäre eine klassische Masche, die Betrüger schon seit Jahrzehnten benutzen. Ein Problem: verdächtiges Verhalten erkenne man oft erst dann, wenn man die Person auch kenne, sagt Martin Förtsch.

Technisch könne man laut Endres auf Folgendes achten: Sieht zum Beispiel die Haut auf einem Foto oder in einem Video weniger detailliert aus als der Rest des Bildes? Gibt es unübliche Verzerrungen im Gesichtsbereich? „Was zum Beispiel unsere Software gerne macht, ist, einer Person unterschiedliche Anzahl an Zähnen zu geben, wenn sie lächelt. Die Zahnlücken sind nicht immer an derselben Stelle“, sagt Endres.

Bei Live-Deepfakes sei es einfacher, eine Fälschung zu entlarven: Schöpfe man während des Gesprächs Verdacht, könne man die Person bitten, ihre Hand vors Gesicht zu halten. „Dann bricht die Gesichtserkennung“, sagt Förtsch. Der Algorithmus wird dadurch verwirrt, die Illusion verschwindet.

Das BSI rät, auf verwaschene Konturen, kleine Störungen im Bild, begrenzte Mimik oder unstimmige Beleuchtung zu achten. Bei Audios sind es ein metallischer Sound, falsche oder monotone Aussprache, falsche Sprechweise, unnatürliche Hintergrundgeräusche oder eine hohe zeitliche Verzögerung, die Menschen misstrauisch machen sollten.

Februar 2021

„Deep Tom Cruise“ wird zum viralen TikTok-Phänomen. Ein Schauspieler, der Tom Cruise ähnlich sieht, und ein Visual-Effects-Spezialist arbeiten zusammen, um einige der beeindruckendsten öffentlichen Deepfakes zu erstellen.

Auch spezialisierte Software kann helfen, Deepfakes erkennen. Häufig brauche es Expertinnen und Experten, um die Ergebnisse zu interpretieren, warnt Martin Steinebach. „All diese Tools sind nicht perfekt, weil sie vielleicht der technischen Entwicklung schnell hinterherhinken, nicht für jeden verfügbar oder bedienbar sind – und dadurch im Zweifel für mehr Verwirrung sorgen“, warnt auch Sam Gregory. Auch politische Regulierungen könnten helfen, die Verbreitung und Anwendung von Deepfakes einzuschränken. Doch während die Technologie immer besser wird, stecken die Gesetze noch in den Kinderschuhen. Im Regulierungsentwurf der EU-Kommission zur Festlegung von Vorschriften für den Einsatz von Künstlicher Intelligenz von April 2021 heißt es, KI-Systeme, die ein Risiko für die Gesundheit, Sicherheit oder Grundrechte von Personen darstellen können, dürfen in der EU nur mit Auflagen in Verkehr gebracht werden und müssten Bewertungsverfahren durchlaufen. Zudem fordert die Kommission eine Pflicht, Deepfake-Inhalte klar als solche zu kennzeichnen, zum Beispiel über einen Warnhinweis.

Dezember 2020

Der Youtube-Nutzer Shamook lädt das Video „The Mandalorian Luke Skywalker Deepfake“ hoch. Sein junger Luke Skywalker sieht besser aus als die computeranimierte Maske in der Hollywood-Version. Lucasfilm, die Produktionsfirma hinter Star Wars, stellt Shamook später ein.

Bisher spielen Deepfakes für deutsche Strafverfolgungsbehörden eine untergeordnete Rolle

Wir haben bei mehreren Strafverfolgungsbehörden in Deutschland nachgefragt, wie sie das Thema einschätzen. Sie seien sich der potenziellen Gefahren von Deepfakes bewusst, bislang sei jedoch lediglich in Einzelfällen ermittelt worden. Wie viele genau, ist unklar – in den Kriminalstatistiken werden Deepfakes nicht extra erfasst.

Das Landeskriminalamt (LKA) Saarland berichtet von Fällen im Zusammenhang mit Erpressung, Diskreditierung von Personen oder Betrug. Eine Pressesprecherin des LKA Nordrhein-Westfalen schrieb uns: „Eine Häufung dieses Deliktbereichs ist (noch) nicht festzustellen. Allerdings ist davon auszugehen, dass zukünftig solche Techniken bei der Tatausführung eine deutlich größere Rolle spielen werden.“ Es sei notwendig, entsprechendes Wissen dafür in Polizeibehörden und LKAs zu schaffen.

Ähnliches schrieb uns die Berliner Senatskanzlei. Auf Rückfrage teilte ein Pressesprecher mit, Beschäftigte würden regelmäßig für das Thema sensibilisiert. Aber: Die technischen Möglichkeiten, um sich automatisch vor Deepfakes und Ähnlichem zu schützen, seien noch in der Erforschung.

Wie groß ist also die Gefahr durch Deepfakes? Fest steht: Die Technologie bietet die Möglichkeit, in Zukunft immer größeren Schaden anzurichten. Doch bislang sind die Vorfälle vereinzelt, Desinformation durch Deepfakes eher ein Randphänomen. Beispiel Russland-Ukraine-Krieg: Laut Sam Gregory kursiert während des Krieges zwar eine Vielzahl oberflächlich gefälschter und inszenierter Videos, aber Deepfakes spielten bislang kaum eine Rolle. Auch uns begegnen solche Fälschungen in unserer täglichen Arbeit gegen Desinformation bislang kaum.

Allerdings reichen schon Cheap-Fakes für wirksame Manipulation aus. Deshalb ist das wachsende Potenzial von Deepfakes vor allem eins – eine Warnung.

Redigatur: Alice Echtermann und Matthias Bau

Grafik und Design: Belén Ríos Falcón