Zwölf Arten, Bots zu erkennen

Bots − vollautomatisierte Medienkonten, die sich als reale Personen ausgeben − haben eine immense Präsenz auf Plattformen wie etwa Twitter. Ihre Zahlen gehen in die Millionen, einem Botnetzwerk können bis zu 500.000 Konten zugeordnet werden.

© unsplash.com / Oliver Shou

Bots können Debatten ernsthaft beeinflussen, insbesondere, wenn sie orchestriert werden. Sie können dazu genutzt werden, um eine Aussage zu treffen oder einen Hashtag-Trend auszulösen, wie das @DFRLab an dieser Stelle zeigt; sie können zur Verstärkung einer Nachricht, eines Artikels oder als Angriff auf diese genutzt werden; sie können auch zur Belästigung anderer Nutzer verwendet werden.

Gleichzeitig ist es recht einfach, Bots und die sogenannten Botnetze zu erkennen, ohne Zugang zu speziellen Programmen oder kommerziellen Werkzeugen zur Analyse zu haben. Dieser Artikel zeigt ein Dutzend Möglichkeiten auf, die wir am nützlichsten finden, um falschen Konten, auch Fake Accounts genannt, auf die Spur zu kommen.

Erstes Prinzip

Ein Twitter-Bot ist, einfach gesagt, ein Konto, das von einem Programm gesteuert wird, ähnlich funktionierend wie ein Flugzeug, das im Autopilot-Modus geflogen wird. So wie der Autopilot-Modus beim Flugzeug an- und abgeschaltet werden kann, so können zu unterschiedlichen Zeiten auch Nutzerkonten wie Bots oder Menschen auftreten. Die unten aufgezeigten Möglichkeiten, die unten angeführt sind, sollten darum vielmehr als Indikatoren für bot-artiges Verhalten zu einer bestimmten Zeit angesehen werden, nicht als eine gegenpolige Definition dessen, ob ein Konto nun ein Bot ist oder von einem Menschen genutzt wird.

Nicht alle Bots haben einen bösartigen oder politischen Hintergrund. Automatisierte Nutzerkonten können beispielsweise etwa Gedichte, Fotografien oder aktuelle Nachrichten veröffentlichen, ohne dadurch eine Beeinflussung hervorzurufen.

Unser Fokus liegt darum auf Bots, die menschlich wirken und politische Botschaften verstärken.

In jedem Fall ist es wichtig anzumerken, dass ein einzelner Faktor nicht ausreicht, um bot-artiges Verhalten ausmachen zu können. Es ist die Zusammenstellung von Faktoren, die entscheidend ist. Nach unserer Erfahrung sind die bedeutendsten Faktoren zur Identifikation von Bot-Konten die „Drei As“: Aktivität, Anonymität und Amplifikation (Verstärkung).

1. Aktivität

Der offensichtlichste Indikator für ein automatisiertes Nutzerkonto ist seine Aktivität. Anhand eines Blicks auf die Nutzerseite, die Anzahl an Veröffentlichungen und die Anzahl an Tagen, seitdem das Konto eröffnet wurde, ist eine hohe Aktivität per Division leicht zu berechnen. Um das genaue Datum der Kontoerstellung herauszufinden genügt bei Twitter ein Mauswisch über den „Beigetreten…“-Vermerk.

Bildschirmfoto, das das Beitrittsdatum von @Sunneversets100 zeigt, aufgenommen am 28. August. Das Nutzerkonto wurde am 13. Januar 2017 und wiederum am 28. August 2017 archiviert und zeigt die Veränderung in der Art der Veröffentlichungen.

Der Richtwert für verdächtige Aktivität schwankt. Das Computer-Propaganda-Team des Oxford Internet Instituts wertet einen Mittelwert von mehr als 50 Veröffentlichungen am Tag als verdächtig; das ist ein weitgehend anerkannter und angewendeter Maßstab, mag sich jedoch im unteren Bereich befinden.

Das @DFRLab wertet 72 Tweets am Tag als verdächtig, das sind über einen Zeitraum von zwölf Stunden ein Tweet alle zehn Minuten. Mehr als 144 Tweets am Tag wertet es als hochverdächtig.

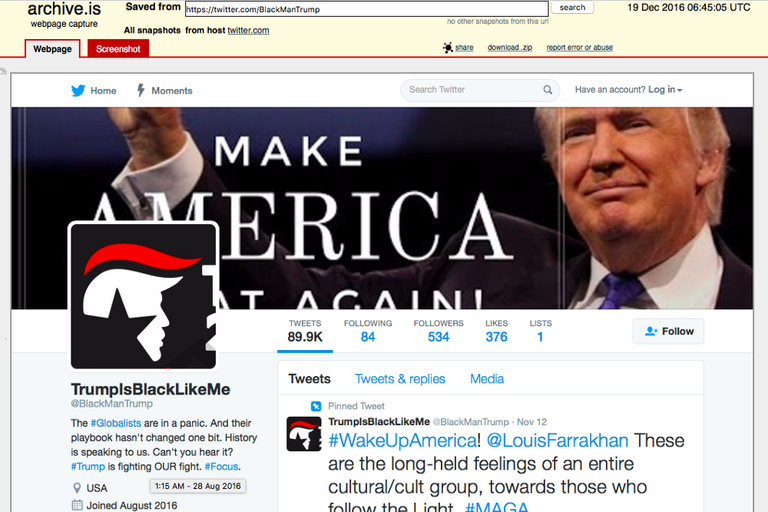

Beispielsweise wurde das Konto @sunneversets100, ein Verstärker von Kreml-nahen Botschaften, am 14. November 2016 erstellt. Am 28. August 2017 war es 288 Tage alt. In diesem Zeitraum veröffentlichte es 203.197 Tweets. Auch hier ist für eine genaue Anzahl wieder der Mauswisch über „Tweets“ anzuwenden.

Dieses Verhalten lässt sich in eine Aktivität von 705 Tweets am Tag übersetzen, das entspricht über einen Zeitraum von zwölf Stunden knapp einen Tweet pro Minute, jeden Tag über neun Monate. Das kann nicht als menschliches Verhaltensmuster gewertet werden.

2. Anonymität

Der zweite Indikator unserer „Drei As“ ist der Grad an Anonymität, die ein Konto aufweist. Je weniger persönliche Information ein Nutzerkonto grundsätzlich angibt, desto wahrscheinlicher handelt es sich um einen Bot. Zum Beispiel hat @sunneversets100 ein Bild einer Florentiner Kathedrale als Profilbild, ein unvollständiges Bevölkerungsdiagramm als Hintergrundbild sowohl einen anonymen Nutzernamen als auch einen Anzeigenamen. Das einzige Alleinstellungsmerkmal ist eine Verknüpfung zu einer in den Vereinigten Staaten liegenden politischen Aktionsgruppe; das ist jedoch überhaupt nicht ausreichend für eine persönliche Zuordnung.

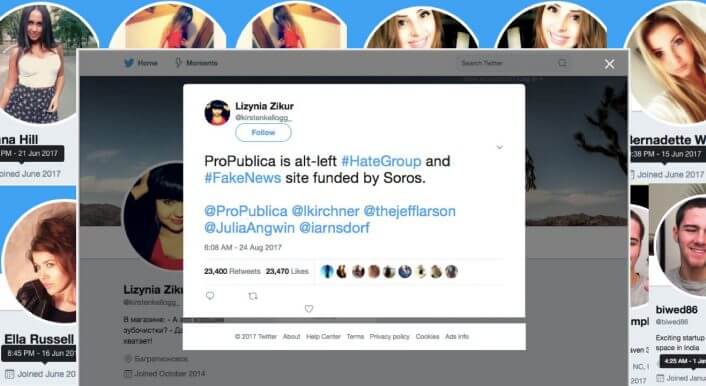

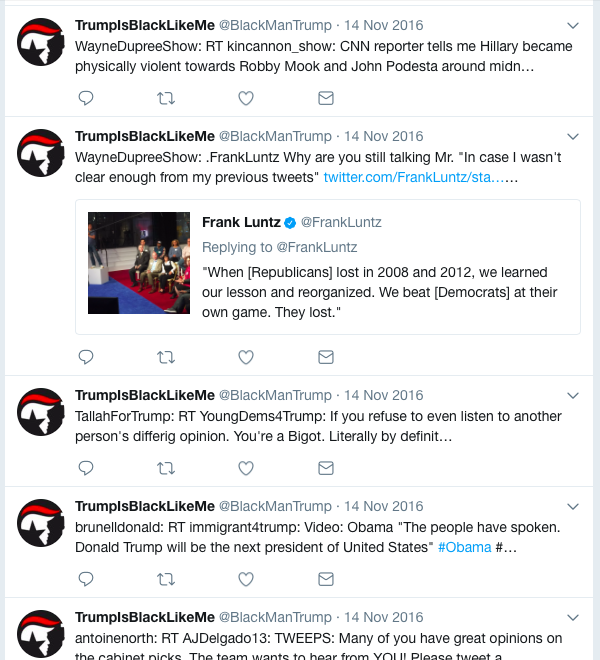

Ein anderes Beispiel ist das Konto von @BlackManTrump, einem weiteren Nutzerkonto mit einer sehr hohen Aktivität, das zwischen dem 28. August 2016 und dem 19. Dezember 2016 89.944 Tweets veröffentlichte (siehe Archiv). Das entspricht einem Mittelwert von 789 Tweets am Tag.

Bildschirmfoto, das das archivierte Profil von @BlackManTrump zeigt, aufgenommen am 28. August. Links unten befindet sich das Kontoerstellungsdatum, oben rechts befindet sich das Datum, an dem das Archiv erstellt wurde.

Dieses Konto gibt überhaupt keine persönlichen Informationen an. Das Profilbild als auch der Hintergrund sind unspezifisch, die Ortsangabe „USA“ ist ungenau und die Nutzerangaben sind politische Aussagen. Anhand dieser Allgemeinplätze ist kein Hinweis auf die Person hinter dem Profil zu erkennen.

3. Verstärkung

Der dritte Hauptindikator ist die Verstärkung von Botschaften. Eine zentrale Rolle von Bots ist es, Veröffentlichungen anderer Nutzer zu verbreiten, sei es durch sogenannte Retweets (das Teilen eines Tweets), Gefällt mir-Angaben (sogenannte „Likes“) oder deren Zitate. Die Chronik eines typischen Bots besteht darum überwiegend aus einer Parade von Retweets und wortgenauen Zitaten von Schlagzeilen aktueller Nachrichten, und nur vereinzelt oder gar nicht auftretenden individuellen Veröffentlichungen.

Die wirksamste Art, dieses Muster herzustellen ist eine maschinelle Überwachung einer großen Anzahl an Veröffentlichungen. Jedoch kann es auch einfacher sein, mit einem geschulten Auge Bots zu identifizieren, etwa durch das Anklicken des „Tweets und Antworten“-Reiters eines Nutzerkontos und des Lesens seiner letzten 200 Veröffentlichungen. Die Zahl 200 dient als Richtwert und wird angegeben, um Wissenschaftlern und Wissenschaftlerinnen eine vernünftige und verarbeitbare Probe zu ermöglichen; selbstverständlich können geübtere Augen ein Mehr an Datensätzen verarbeiten.

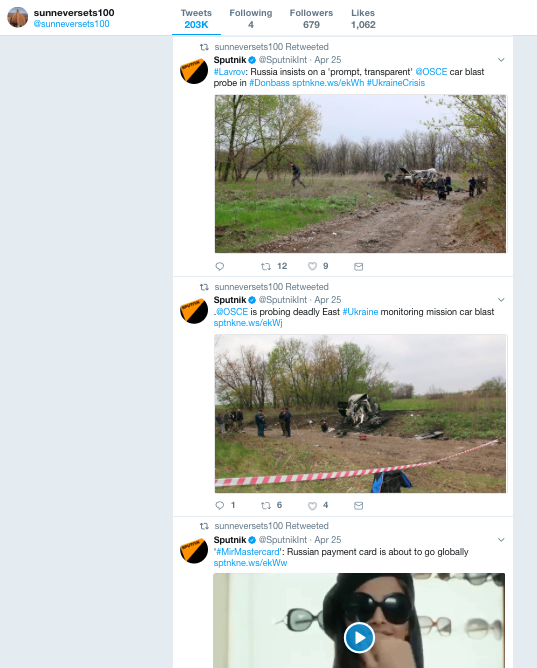

So waren zum Beispiel 195 der 200 von @sunneversets100 bis zum 28. August veröffentlichten Tweets sogenannte Retweets, darunter viele, die ursprünglich von Kreml-nahen Nachrichtenagenturen RT und Sputnik als Tweet veröffentlicht wurden.

Bildschirmfoto, das die Chronik von @sunneversets100 am 28. August zeigt. Viele der Retweets sind ursprünglich Tweets vom Konto der kreml-nahen Nachrichtenagentur Sputnik. Bemerkenswert ist die Inaktivität von @sunneversets100 seit Ende April.

Ein weiterer Grad an Raffinesse zeigt die Veränderung des Veröffentlichungsmusters von @BlackManTrump bis zum 14. November 2016. Bis dahin beinhalteten alle Retweets die für Bots bis dato verratende Vorsilbe „RT @“, nach dem 14. November tauchte dieser Zusatz nicht mehr auf.

Botschaften von @BlackManTrump im November 2016. Bemerkenswert ist der Beginn eines jeden Tweets mit einem Nutzernamen und einem Doppelpunkt, der den Eindruck vermittelt, dass diese Retweets sind, aus denen die typische Vorsilbe „RT @“ entfernt wurden.

Aufgrund der drei angewendeten Faktoren auf die Konten von @BlackManTrump als auch @sunneversets100, die klar erkennbar bothaftes Verhalten aufweisen, können diese Profile als Bots angesehen werden.

Beachtenswert ist, dass @BlackManTrump vom 14. November bis zum 13. Dezember 2016 keine Aktivität zeigte; als das Profil seine Veröffentlichungen wieder aufnahm, tat es das mit einer viel geringeren Frequenz und einer höheren Anzahl an scheinbar individuellen Tweets. Darum ist es korrekt zu sagen, dass dieses Konto bis Mitte November bothaftes Verhalten zeigte, jedoch nicht, dass es sich derzeit um einen Bot handelt.

Eine weitere Art der Verstärkung ist es, einen Bot zu programmieren, um aktuelle Nachrichten kommentarlos direkt von ausgewählten Seiten zu teilen. Direkte Retweets machen natürlich einen üblichen Anteil am Verkehr auf Twitter aus (Leser und Leserinnen sind etwa gern dazu eingeladen, diesen Artikel zu teilen), und an sich ist das nicht auffällig. Dennoch sind Konten, die über einen langen Zeitraum unkommentierte Veröffentlichungen teilen, vermutlich Bots, wie etwa dieses gegen US-Präsident Donald Trump gerichtete Profil, das im Juli als solches identifiziert wurde:

Bildschirmfoto des Profils @ProletStrivings vom 28. August 2017; beachtenswert ist das kommentarlose Kopieren der Schlagzeile in den geteilten Tweet. Das Konto wurde am 28. August archiviert.

4. Wenig Veröffentlichungen/hohes Engagement

Die oben genannten Bots erzielen ihren Effekt durch die immense Verstärkung von Inhalten eines einzelnen Kontos. Ein anderer Weg mit dem gleichen Effekt ist es, große Anzahlen an Konten zu erstellen, die den selben Inhalt jeweils einmal retweeten: ein Botnetz.

Solche Botnetze können schnell identifiziert werden, wenn sie dazu genutzt werden, eine einzelne Botschaft zu verstärken, wenn das ursprüngliche Profil unregelmäßig aktiv ist.

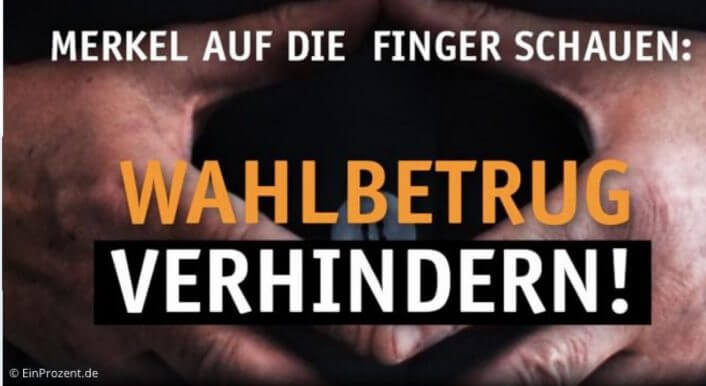

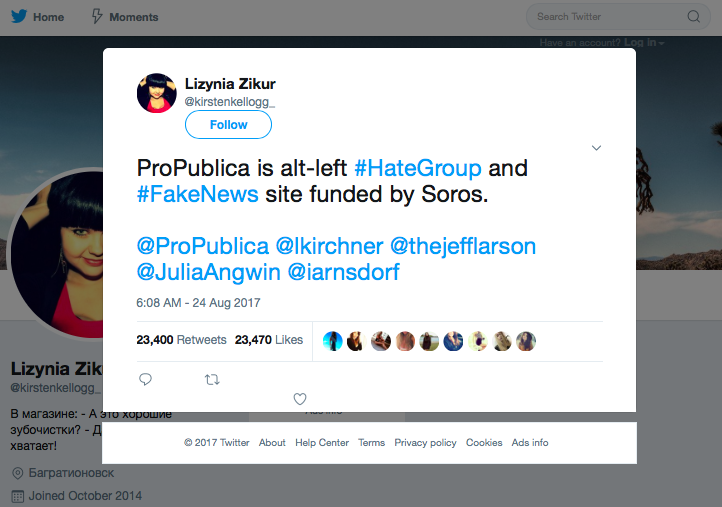

Beispielsweise veröffentlichte ein Konto mit dem Namen @KirstenKellog_ (mittlerweile ist es gesperrt, aber hier archiviert worden) einen Tweet, der das Medienunternehmen ProPublica angreift.

Profilseite von @KirstenKellog_, das die Anzahl an Tweets und folgenden Konten anzeigt als auch diese eine sichtbare Veröffentlichung. Archiviert am 24. August 2017.

Wie das Bild oben zeigt, handelte es sich hierbei um ein Profil mit sehr geringer Aktivität. Es hatte insgesamt nur zwölf Mal etwas veröffentlicht, elf Tweets davon wurden gelöscht. Es hatte 76 Konten, die ihm folgten und folgte selbst keinem.

Dennoch wurde dieser Tweet mehr als 23.000 Mal retweetet und als gemocht markiert (sogenannte „Likes““oder als Verb „liken“).

Der Tweet und seine Anzahl an Retweets und Likes. Archiviert am 24. August 2017.

In ähnlicher Weise tätigte ein weiteres, offenbar russisches Profil eine fast identische Attacke, diese erzielte über 12.000 Retweets und Likes:

Der darauffolgende Angriff. Archiviert am 25. August 2017. Bis zum 28. August erzielte er mehr als 20.000 Retweets und Likes. Dieses Konto ist ebenfalls inaktiv, bislang veröffentlichte er sechs Tweets, den ersten am 25. August, und er folgte fünf Profilen:

Das Profil des nachfolgend angreifenden Nutzerkontos. Es ist nicht plausibel, dass zwei ähnlich inaktive Konten in der Lage sind, derart viele Retweets zu erzeugen, auch unter der Berücksichtigung der verwendeten mit Raute versehenen Schlagworte (sogenannte „Hashtags“) #FakeNews (zu Deutsch „Falschmeldungen“) und #HateGroup (zu Deutsch „Hassgruppe“). Die Diskrepanz zwischen ihrer Aktivität und ihres Einflusses lässt vermuten, dass die Profile, die die Tweets der beiden Konten verstärkten, einem Botnetz zuzuordnen sind.

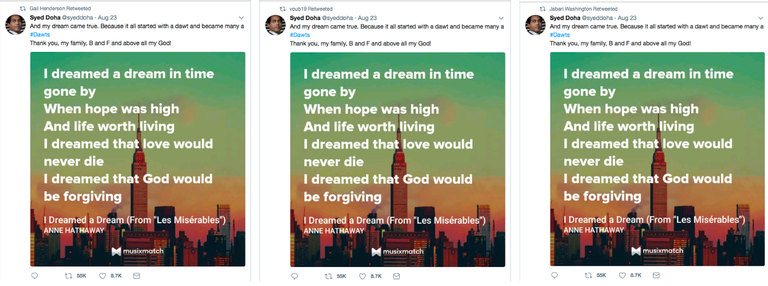

5. Gemeinsame Inhalte

Die Wahrscheinlichkeit, dass Konten zu einem einzigen Netzwerk gehören, kann durch das Ansehen ihrer Tweets bestätigt werden. Sofern alle die gleichen Inhalte oder Arten von Inhalten zur gleichen Zeit veröffentlichen, ist es naheliegend, dass sie programmiert wurden, genau dies zu tun.

Innerhalb des im Verdacht stehenden Botnetzes, das den Tweet von @KirstenKellog_ beispielsweise verstärkte, fanden sich viele Konten, die dieselben Botschaften veröffentlichte, wie etwa diese hier:

Identische Retweets von „Gail Harrison“, „voub19“ und „Jabari Washington“, die ebenfalls @KirstenKellog_ verstärkten.

Manchmal teilen Bots ganze Reihen an Tweets in der gleichen Anordnung. Diese drei unten angeführten Konten sind Teil des selben Anti-Trump-Netzwerks, das als solches im Juli identifiziert wurde:

Von links nach rechts: Identische Tweets in derselben Reihenfolge, jeweils am 26. Juli von @CouldBeDelusion, @ProletStrivings und @FillingDCSwamp. Beachtenswert ist auch die Art, in der die Veröffentlichungen die Schlagzeilen der Artikel, die sie teilen.

Am 28. August haben diese drei Profile wieder in der gleichen Reihenfolge Tweets geteilt; @ProletStrivings fügte einen Retweet hinzu:

Von links nach rechts: Bildschirmfotos der Profile von @CouldBeDelusion, @FillingDCSwamp und @ProletStrivings, die die gleiche Reihenfolge an geteilten Tweets aufweisen. Zu beachten ist der Text „Check out this link“ (zu Deutsch „Schaut euch diesen Link an“), in jeweils jedem ersten Tweet, vermutlich eine Markierung einer anderen automatisiert geteilten Botschaft. Die Bildschirmfotos und Archive wurden am 28. August erstellt.

Solche identischen Tweet-Reihen sind klassische Anzeichen für Automatisierung.

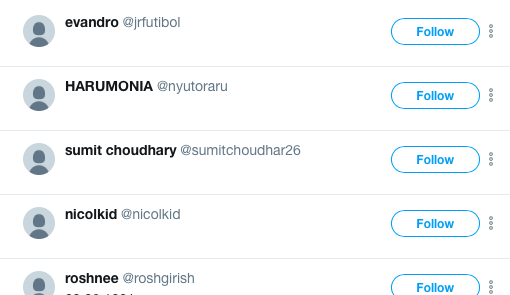

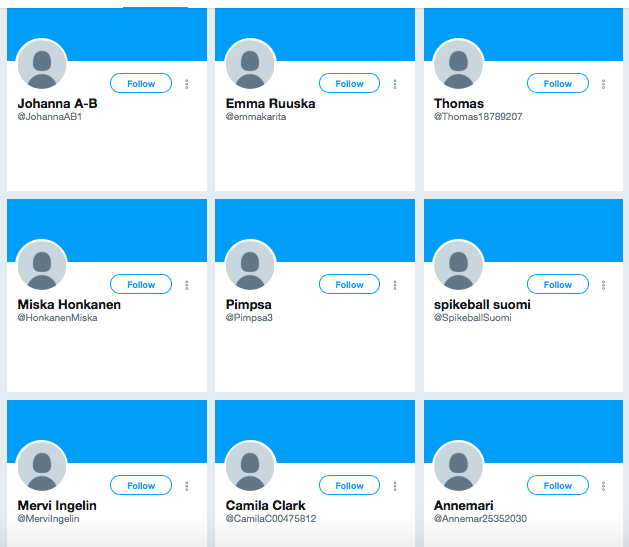

6. Die geheime Gesellschaft der Silhouetten

Die einfachsten Bots sind besonders leicht auszumachen, da sich ihre Ersteller und Erstellerinnen keine Mühe gemacht haben, den Konten ein Profilfoto zuzuweisen. Früher wurden solche Profile „Eier“ genannt, das entstammt einer Zeit als Twitter als Standard-Profilbild ein Ei anzeigte. Heute stellen diese standardisierten Profilbilder menschliche Silhouetten dar.

Einige Nutzer nutzen Silhouetten als Profilbild aus den unverfänglichsten Gründen, darum kann man dieses Phänomen nicht als einen Indikator für Botkonten werten. Allerdings ändert sich das, sobald eine Anzahl von Konten, die retweeten und liken, folgendermaßen aussehen:

Bildschirmfoto einer Liste von retweetenden Konten eines Tweets von @AtlanticCouncil, der am 28. August signifikant von Bots verstärkt wurde.

… oder wenn die folgenden Konten (sogenannte „Follower“) eines Profils den Eindruck erwecken, einen Ort für die „geheime Gesellschaft der Silhouetten“ zu bilden …

Bildschirmfoto der Follower-Seite der finnischen Journalistin @JessikkaAro, nachdem ihr Profil am 28. August unerwartet von Bots ausgemacht wurde.

… dann ist das ein sicheres Zeichen für Bot-Aktivität.

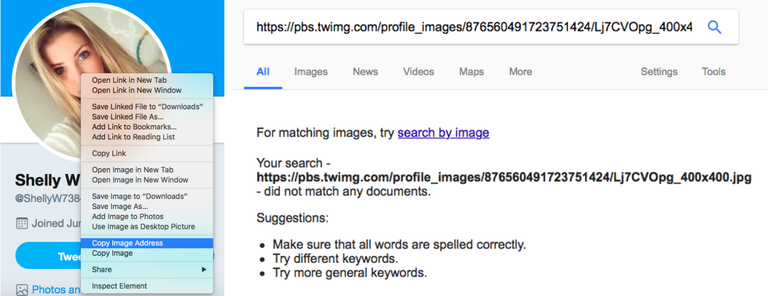

7. Entwendetes, beziehungsweise geteiltes Profilfoto

Andere Bot-Ersteller und -Erstellerinnen gehen sorgfältiger vor und verschleiern die Anonymität, indem sie Profilfotos von anderen Quellen verwenden. Das dient einer guten Möglichkeit, ein Konto und sein Profilbild auf Echtheit zu überprüfen, dazu bedient man sich Werkzeugen wie der sogenannten „Reverse Image Search“ („rückwärts gerichtete Bildersuche“). Nutzt man als Browser Google Chrome, genügt ein Rechtsklick auf das Bild und die Auswahl des Reiters „Mit Google nach Bild suchen“.

Sie Suche mit Google nach dem Profilfoto von „Shelly Wilson“, einem wahrscheinlichen Bot.

Bei der Verwendung anderer Browser wählt man nach dem Rechtsklick „Bildadresse kopieren“ aus, gibt diesen Link dann in die Google-Suche ein, drückt „Enter“ und klickt dann auf den Reiter „Bilder“.

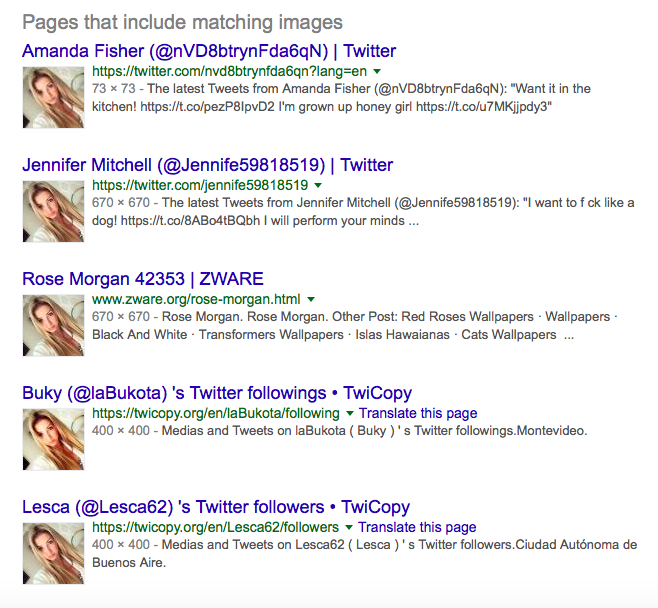

In beiden Fällen wird die Suche Seiten mit passenden Bildern anzeigen, die wiederum einen Hinweis darauf geben, ob ein Profilbild wahrscheinlich für ein Bot-Konto entwendet wurde:

Im Fall von „Shelly Wilson“ teilen sich einige Twitterkonten das gleiche Profilbild, wodurch diese Konten Botkonten zugeordnet werden konnten:

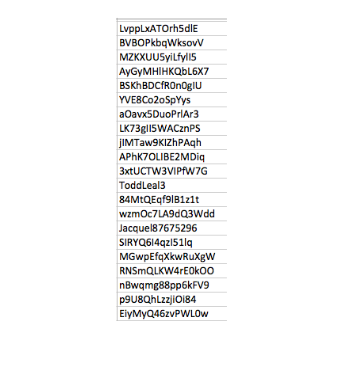

8. Bot im Namen?

Ein weiterer Hinweis auf einen wahrscheinlichen Bot ist der gewählte Handle („Nutzername“, bei Twitter beginnend mit einem „@“). Viele Bots haben Handles, die lediglich alphanumerische Chiffren, die von einem Algorithmus erstellt wurden, enthalten. Dazu gehören etwa solche:

Twitter-Handles mancher Bots, die @KirstenKellog_ retweetet haben, entsprachen diesem Muster. Bemerkenswert ist der einzig als Name erscheinende Handle, @ToddLeal3, auf den später eingegangen werden wird.

Andere Bots weisen einen menschlich erscheinenden Namen im Profil auf, der jedoch nicht mit dem Handle übereinstimmt:

Von links nach rechts: Sherilyn Matthews, Abigayle Simmons und Dorothy Potter, deren Handles sich NicoleMcdonal, Monique Grieze und Marina nennen.

Es gibt auch Bots, die einen typisch männlichen Namen aufweisen, aber deren Profilbild eine Frau zeigt (eine Begebenheit, die bei Bots weit häufiger aufzutreten scheint als dass sie einen weiblich klingenden Handle nutzen, jedoch einen Mann im Profilbild zeigen) …

Drei weitere Konten des selben Botnetzes: Todd Leal, James Reese und Tom Mondy, archiviert am 24. und 28. August 2017.

… oder männlich klingende Handles, mit weiblichen Namen und Profilbildern von Frauen…

Von links nach rechts: „Irma Nicholson“, „Poppy Townsend“ und „Mary Shaw“, deren Handles auf die männlichen Namen David Nguyen, Adrian Ramirez und Adam Garner verweisen.

… oder aber etwas gänzlich anderes.

Erik Young, eine Frau, die Jesus liebt, aus dem selben Botnetz.

Alles deutet darauf hin, dass das Konto ein Fake ist, das eine Person (oft eine junge Frau) vortäuscht, die Aufmerksamkeit auf sich zu ziehen versucht. Wie man feststellt, um welche Art von Fake es sich handelt oder ob es sich um einen Bot handelt, hängt von seinem Verhalten ab.

9. Das Twitter von Babel

Manche Bots sind politisch und twittern stets die gleiche Position. Andere wiederum werden kommerziell genutzt und machen den Anschein, vom höchsten Bieter erworben worden zu sein, ohne Rücksicht auf die Inhalte der Chronik des Botprofils. Die meisten jener Konten sind unpolitisch, können jedoch auch dazu genutzt werden, politische Botschaften zu verstärken.

Solche Botnetze sind oft von großer sprachlicher Unterschiedlichkeit gezeichnet. So zeigt etwa ein Blick auf die Retweets von Erik Young, der „Frau, die Jesus liebt“, dass dieses Konto Inhalte auf Arabisch, Englisch, Spanisch und Französisch verbreitet:

Ein ähnlicher Blick auf Inhalte vom anonymen und profilbildlosen Konto @multimauistvols (Anzeigename „juli komm“) zeigt Tweets auf Englisch …

… Spanisch…

… Arabisch…

… Swahili (dem Übersetzungsdienst Google Translate zufolge)…

… Indonesisch…

… Chinesisch…

… Russisch…

… und auf Japanisch.

Im physischen Leben hat vermutlich jeder und jede, der oder die all diese Sprachen beherrscht, vermutlich besseres zu tun als YouTube-Videos zu bewerben.

10. Kommerzielle Inhalte

Tatsächlich ist Werbung ein klassischer HInweis auf Botnetze. Wie oben ausgeführt, scheinen Botnetze vornehmlich für diesen Zweck zu existieren, mit geringerer Nutzung für politische Botschaften. Wenn sie dazu verwendet werden, verrät ihre vormalige Verwendung zu Werbezwecken sie oftmals als Bots.

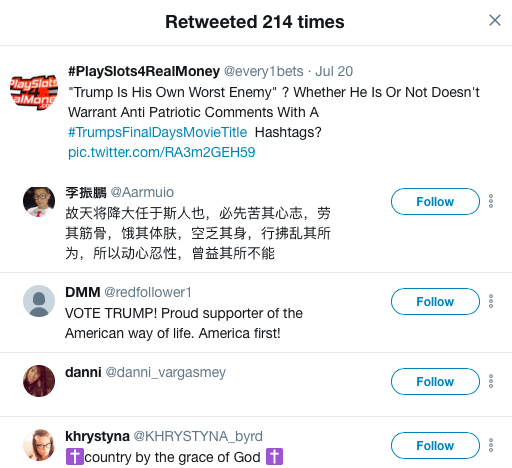

Ein gutes Beispiel dafür ist das sonderbare Botnetz, das eine politische Botschaft des Kontos @every1bets retweetete, das üblicherweise zur Glücksspielwerbung genutzt wird.

Die retweetenden Konten wiesen unterschiedlichste Identitäten auf, wie die folgende Liste zeigt:

Gemein hatten diese Konten lediglich die hohe Anzahl an Werbetweets.

Profile, die eine hohe Anzahl an Retweets dieser Art aufweisen, insbesondere in mehreren Sprachen, sond meistens Teil eines kommerziellen Botnetzes, die dazu erworben wurden, um Botschaften von Nutzern und Nutzerinnen zu bewerben und zu verstärken.

11. Automatisierungsprogramme

Ein weiterer Hinweis auf die wahrscheinliche Automatisierung von Konten ist die Verwendung von URL-Kürzungsdiensten (URL steht für Webadresse). Diese werden vornehmlich dazu genutzt, die Aufrufzahlen für einen bestimmten Link zu überwachen, allerdings kann die Häufigkeit der Verwendung solcher Dienste ein Automatisierungsindikator sein.

Zum Beispiel teilte das als Bot identifizierte Konto Angee Dixson, das als Profilbild das Gesicht des deutschen Supermodels Lorena Rae nutzte, eine große Anzahl an rechtspopulistischen Botschaften. Jeder dieser Tweets zeichnete sich durch die Verwendung von Links, die mithilfe des URL-Kürzungsdiensts ift.tt erstellt wurden, aus:

URL-Kürzungsdienste sind Programme, die zum Beispiel von der Firma ifttt.com produziert werden. Deren Nutzung erlaubt es Profilen ihre Tweets nach einer Reihe von Kritierien zu automatisieren, etwa dem Retweeten eines Tweets mit einem festgelegten Hashtag. Eine Chronik, die voller ift.tt-Kürzungen ist, ist demnach wahrscheinlich die eines Botkontos.

Die Verwendung anderer URL-Kürzungsdienste kann ebenfalls ein Anzeichen für Automatisierung sein, wenn die sie wiederholt in einer Chronik auftauchen. Beispielsweise ist der Kürzungsdienst ow.ly an die Social-Media-Verwaltungsplattform HootSuite geknüpft; manche Botkonten sind dafür bekannt gewesen, lange Reihen von geteilten Tweets, die durch ow.ly erstellt wurden, aufzuweisen. Der Twitter-eigene Dienst TweetDeck ermöglicht es Nutzern und Nutzerinnen, eine Vielzahl an URL-Kürzungsdiensten zu verwenden, darunter bit.ly und tinyurl.com.

Auch hier gilt, dass die Verwendung solcher Dienste Teil des virtuellen Lebens ist, allerdings sollten Konten, die diese Dienste inflationär nutzen, auf eine mögliche Botexistenz geprüft werden.

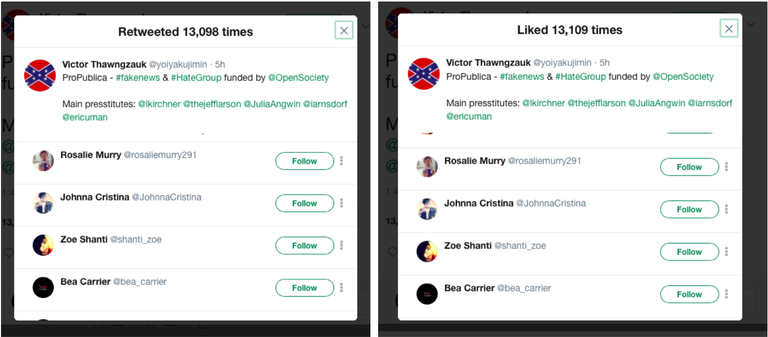

12. Retweets und Likes

Ein letzter Hinweis auf das Werk eines Botnetzes kann durch das Vergleichen von Retweets und Likes einer bestimmten Botschaft eingeholt werden. Manche Bots sind dazu programmiert, Tweets sowohl zu retweeten als auch zu liken. In jenem Fall ist die Anzahl der Retweets und Likes eines solchen Profils nahezu identisch, ebenso die Chronik-Reihenfolge mehrerer miteinander verglichener Konten. Dazu folgendes Beispiel:

Beim zweiten Konto des Angriffs auf ProPublica.com sind links sind Retweets zu sehen, rechts Likes.

In diesem Beispiel ist die Differenz zwischen der Anzahl an Retweets und Likes lediglich elf Antworten — das ist ein Unterschied von weniger als 0,1 Prozent. Ebendiese Konten retweeteten und liketen den Tweet, in der gleichen Reihenfolge und zur gleichen Zeit. Bei einer Probe von 13’000 Profilen ist es sehr unwahrscheinlich, dass es sich hierbei um einen Zufall handelt. Sie weist auf die Existenz eines koordinierten Botnetzwerks hin, das dazu programmiert wurde, denselben Angriff zu liken und zu retweeten.

Zusammenfassung

Bots sind ein existentieller Bestandteil des Lebens auf Twitter. Viele sind vollkommen legitim; jene, die es nicht sind, neigen dazu, Kerncharakteristika gemein zu haben.

Die häufigsten dieser Charakteristika sind Aktivität, Anonymität und Verstärkung (Englisch „amplification“), die sogenannten Drei „As“, doch es existieren weitere Merkmale. Die Nutzung entwendeter Profilbilder, alphanumerische Handles und zusammenhangslose Namen können ein falsches Konto verraten. Auch können dies eine Überzahl an kommerziellen Tweets oder eine Vielzahl an verwendeten Sprachen.

Das wichtigste beim Ausmachen von Bots ist jedoch die Aufmerksamkeit. Nutzer und Nutzerinnen, die Bots selbst identifizieren können, sind weniger anfällig für deren Manipulationsversuche. Sie können dazu fähig sein, Botnetze zu melden und zu deren Ausschluss beitragen. Schlussendlich existieren Bots, um Menschen zu beeinflussen. Das Ziel dieses Artikel ist es, menschlichen Nutzern und Nutzerinnen dabei zu helfen, die Anzeichen dafür ausfindig zu machen.

Ben Nimmo ist Senior Fellow für Nachrichtenabwehr beim digitalen Forschungslabor des Atlantic Councils (@DFRlab). Übersetzt wurde Bens Artikel von Sarina Balkhausen, Fellow bei #Wahlcheck17, einem Pop-Up-Newsrooms zur Bundestagswahl, einer Initiative von CORRECTIV, First Draft, Google News Lab und Facebook. Weder Ben noch Sarina sind Bots.

Wir veröffentlichen den Artikel mit freundlicher Genehmigung von „Medium“.