Wladimir Putin kniend vor Xi Jinping? Woran sich erkennen lässt, dass dieses Bild nicht echt ist

Ein Bild im Netz zeigt den russischen Präsidenten auf den Knien vor dem Staatspräsidenten der Volksrepublik China. Erstellt wurde es scheinbar mithilfe von Künstlicher Intelligenz. Wie man das herausfinden kann, erklärt uns ein Experte.

In Sozialen Netzwerken verbreitete sich am 20. März ein Bild, das scheinbar mithilfe von Künstlicher Intelligenz (KI) erstellt wurde: Es soll den russischen Präsidenten Wladimir Putin kniend vor dem chinesischen Präsidenten Xi Jinping zeigen. Etliche Nutzerinnen und Nutzer kommentierten das Bild scherzhaft oder nannten es „offensichtlichen Unsinn“ (hier und hier). Der USA-Korrespondent der Kyiv Post, Jason Jay Smart, twitterte es mit dem Kommentar: „Putin versucht Xi zu überzeugen“. Die Kommentare darunter zeigen, dass nicht alle Nutzer erkennen, dass das Bild eine Fälschung ist.

Immer öfter verbreiten sich durch KI generierte Bilder, so wie zum Beispiel die Fake-Bilder von Donald Trumps angeblicher Festnahme oder vom Papst in einer weißen Daunenjacke. Schon ihr Beispiel zeigte: Scherzhaft gemeinte Bilder werden in Sozialen Netzwerken manchmal ohne Kontext weiterverbreitet und können so für Verwirrung sorgen. Wir erklären, wie man KI-generierte Bilder enttarnen kann.

Die Fälschung zeigt die Fortschritte einer Technologie, die immer häufiger eingesetzt wird

Das Bild kursierte in unterschiedlichen Sprachen, etwa auf Deutsch, Englisch oder Ukrainisch. Der älteste Beitrag, den wir bei unserer Recherche entdeckten, wurde am 20. März in einem Telegram-Kanal namens News.GRP veröffentlicht, laut Selbstbeschreibung „der schnellste Nachrichten-Aggregator der Ukraine“. Wenige Minuten später verbreitete ein anderer ukrainischer Telegram-Kanal das Foto weiter – der Beitrag wurde mehr als 300.000 Mal gesehen.

Das Bild des knienden Wladimir Putin tauchte im Kontext von Xi Jinpings Besuch in Russland am 20. März 2023 auf. An diesem Tag war der chinesische Staatspräsident laut Medienberichten für ein Treffen mit Putin in Moskau gelandet.

Inzwischen haben mehrere Medien das Bild als Fälschung enttarnt. Doch woran lässt sich das erkennen? Wir haben dazu den Forschungsingenieur David Fischinger vom Austrian Institute of Technology (AIT) gefragt. Er nimmt an, dass das angebliche Bild von Jinping und Putin mithilfe von Künstlicher Intelligenz (KI) erstellt.

Ein nützliches Werkzeug: Die Bilderrückwärtssuche

Ein erstes Indiz dafür liefert eine Bilderrückwärtssuche, wie wir sie hier erklärt haben. Lädt man das Bild von Putin und Jinping bei den Suchmaschinen Google, Tineye oder Yandex hoch und sucht gezielt nach Ergebnissen für den 20. März, erscheinen zunächst Beiträge in Sozialen und Foto-Netzwerken wie Imgur, Twitter oder Linkedin. Keiner der gelisteten Beiträge enthält eine konkrete Quellenangabe für das Bild.

Fischinger erklärt, die Bilderrückwärtssuche sei eine sehr nützliche Methode, um die Echtheit von Bildern zu überprüfen. „Wenn KI-Bilder (von Grund auf) generiert werden, gibt es im Allgemeinen nicht nur ein Originalbild, aus dem die Teile entnommen wurden. Es gibt Tausende/Millionen von Fotos, die zum Lernen von Milliarden von Parametern verwendet wurden.“ Das bedeutet: Das Bild entsteht nicht durch die Manipulation eines vorhandenen Fotos, sondern es wird aus vielen unterschiedlichen Elementen neu erstellt. Deswegen lässt sich in solchen Fällen kein einzelnes Ursprungsbild finden.

Erste Recherche enthüllt Ungereimtheiten

Überprüfen lassen sich KI-generierte Bilder auch mit klassischer Recherche. Was haben Medien an dem Tag berichtet? Wie sieht die Umgebung aus, in der sich Personen befinden? Wer war dabei? Das funktioniert auch beim Bild des knienden Wladimir Putins.

Medien veröffentlichten am 20. März zahlreiche Bilder des Treffens im Kreml, auf denen die Männer in einem völlig anderen Raum zu sehen sind. Der Teppich unter ihnen war nicht rot, wie in der KI-Version, sondern beige. Auch die Stühle hatten statt eines braunen Holzrahmens einen weißen.

Auf der Internetseite der US-Fotoagentur Getty Images und der staatlichen russischen Nachrichtenagentur TASS sind Xi und Putin zwar in unterschiedlichen Räumen zu sehen – doch keiner davon gleicht dem KI-Foto mit dem roten Teppich.

Auffälligkeiten in Fotos erkennen

Generiert KI ein Bild oder Video, kann es manchmal zu optischen Ungereimtheiten kommen. Das Bild von Putin und Xi Jinping zeigt mehrere Auffälligkeiten: Zum Beispiel sieht Putins Kopf ungewöhnlich groß aus, sein Schuh wirkt deformiert – an der Spitze sind unnatürliche Wölbungen zu erkennen. Zudem ist im Hintergrund eine Säule zu sehen, die ungerade verläuft.

Ob manipulierte Bilder in Zukunft weiterhin so leicht zu enttarnen sind, ist dem KI-Forscher Fischinger zufolge fraglich. Schon jetzt seien Porträtfotos deutlich schwieriger zu entlarven. Die Technologie entwickele sich rasant: Die KI-Generierung von Gesichtern habe bereits „ein Qualitätsniveau erreicht“, das es selbst geschulten Menschen schwer mache, zwischen generierten und authentischen Porträtbildern zu unterscheiden, so Fischinger. Vor zwei bis drei Jahren sei das für Menschen, zumindest mit etwas Übung, noch einfacher gewesen.

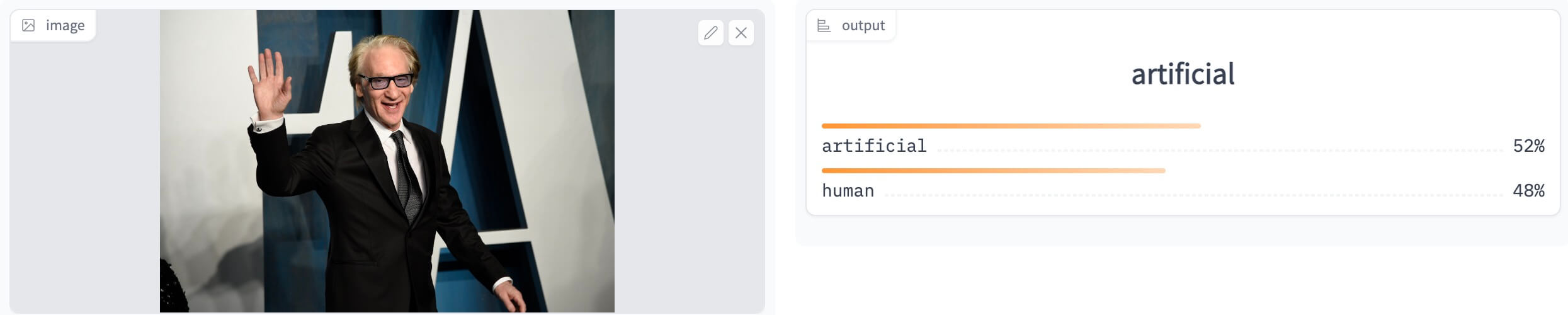

Einige Tools können Einschätzungen liefern, ob Bilder von KI generiert wurden

Unterschiedlichste Internetseiten bieten Werkzeuge an, mit denen sich die Authentizität von Bildern überprüfen lässt. Daraus resultierende Einschätzungen sollten jedoch mit gewisser Vorsicht interpretiert werden, denn sie sind unter Umständen unzuverlässig. Zudem gehen Bildinformationen und -qualität verloren, wenn das Bild in Sozialen Netzwerken immer wieder kopiert und verbreitet wird.

Welches Werkzeug bei einer Einschätzung helfen kann, hängt außerdem davon ab, wie das Bild verändert oder erstellt wurde. So braucht es für den Nachweis eines KI-generierten Fotos andere Werkzeuge als bei Bildern, in die zum Beispiel mit einer einfachen Software andere Teile eingefügt wurden.

Das Foto von Putins Kniefall identifiziert zum Beispiel dieser kostenlose AI-Image-Detector als mögliche KI-Bearbeitung. In einigen Fällen schätzt es aber echte Bilder als Fälschung ein – allein daraus lässt sich folglich nicht auf eine KI-Manipulation schließen.

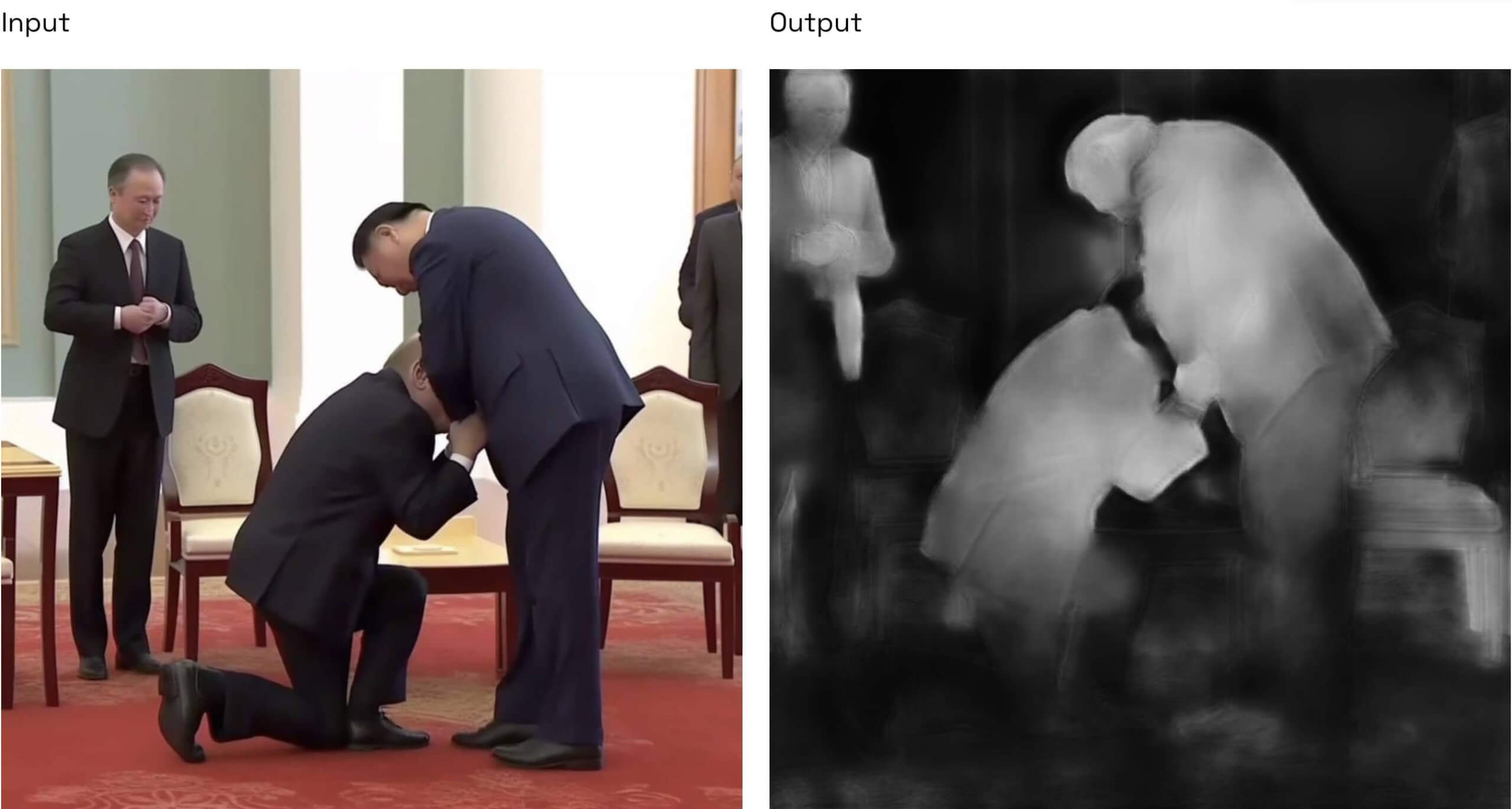

Fischinger überprüfte das Bild darüber hinaus mithilfe des kostenlosen Online-Tools auf der Internetseite Replicate, das allgemeine Bildmanipulationen sichtbar machen kann. „Dem Ergebnis dieser Verfahren ist jedoch nur bedingt zu trauen. Auch deshalb, weil sie dazu dienen, lokale Manipulationen zu entdecken“, so Fischinger. Wurde aber das gesamte Bild von einer Künstlichen Intelligenz erstellt, wären Tools wie dieses nicht geeignet.

Im Fall des Bildes von Putin und Xi funktioniert die Technologie scheinbar. Die weißen Stellen im Bild unten deuten darauf hin, was offenbar manipuliert wurde:

Für manipulierte Bilder, die nur teilweise von einer KI erstellt oder von einer normalen Bildsoftware wie zum Beispiel Photoshop verändert wurden, gibt es im Netz das kostenlose Invid Verification Plugin. Es bietet mehrere Forensik-Filter, die Bildmanipulationen sichtbar machen sollen. Auch hier ist wieder Vorsicht angebracht, denn eindeutig sind diese Ergebnisse nicht – je nachdem, wie das Bild verändert wurde und ob das Originalbild vorhanden ist.

Wer sich bei Bildern im Netz unsicher ist, ob es echt ist, kann diese per E-Mail oder per Whatsapp-Chatbot an CORRECTIV.Faktencheck schicken.

Redigatur: Matthias Bau, Sophie Timmermann